La mancanza di energia è un assillo costante per gli operatori di data center e di analoghe infrastrutture di comunicazione e IT. L’ottimizzazione degli ingombri, abbinata alla necessità di aumentare la potenza di elaborazione e la capacità di memorizzazione, è una sfida continua. In ogni caso è possibile eliminare le inefficienze e il sotto-utilizzo delle attuali infrastrutture di alimentazione che sono progettare per soddisfare i picchi nella domanda utilizzando un’opportuna combinazione di hardware e software in grado di livellare il carico di alimentazione e ottimizzare la capacità disponibile. Per un uso intelligente della potenza disponibile è possibile ricorrere a tool software capaci di profilare l’utilizzo e riconoscere i compiti in base alla priorità. La potenza fornita dalla rete può essere integrata con quella di sistemi di accumulo a batteria per soddisfare i picchi della domanda sfruttando la potenza immagazzinata durante i periodi di basso utilizzo. In maniera del tutto analoga i carichi di lavoro a bassa priorità possono essere assegnati a server rack che sono alimentati solamente quando la capacità di alimentazione è sufficiente. Il sistema può quindi soddisfare i picchi della domanda e gestire gli altri compiti in modo da distribuire il carico di potenza. Più o meno nello stesso modo in cui i data center definiti dal software permettono agli utenti self-service di assegnare servizi e carichi di lavoro nel giro di pochi secondi, questo approccio alla potenza definita via software, o Software Defined Power, permette letteralmente di sbloccare la capacità di potenza sotto-utilizzata all’interno dei sistemi esistenti. Risulta quindi possibile incrementare la capacità di elaborazione e di memorizzazione di un server presente in un data center senza per questo aumentare la capacità dell’alimentatore, nonché conseguire risparmi in termini di spese in conto capitale grazie alla possibilità di prevedere in maniera più accurata i fabbisogni di potenza. Senza dimenticare che l’impiego di sistemi di accumulo a batteria in grado di livellare i carichi e ridurre i picchi può consentire l’uso di funzionalità Ups all’interno di un data center o un server rack per garantire un’adeguata protezione contro il verificarsi di interruzioni dell’alimentazione.

L’elemento centrale dei data center

La richiesta di servizi dati basati su Cloud continua ad aumentare a ritmo sostenuto nel momento in cui aziende e singoli individui fanno sempre più affidamento su dati memorizzati in remoto ai quali è possibile accedere attraverso Internet da qualsiasi luogo. Secondo recenti stime fornite da Cisco, grazie alla diffusione di Internet of Things, entro il 2020 vi saranno 50 miliardi di oggetti connessi a Internet, con una miriade di sensori e controlli che promettono di rendere più intelligenti abitazioni, uffici, fabbriche, ecc. Tutto ciò, abbinato alle applicazioni più consolidate, comporterà un traffico dati giornaliero superiori allo zettabyte (1021 byte) entro il 2018. Soddisfare questa domanda e aumentare la capacità di reti e data center è sicuramente un compito arduo anche in considerazione del fatto che i requisiti degli utenti possono variare rapidamente. Mentre nell’industria informatica la tendenza è aumentare la capacità dei data center, una delle risorse con più vincoli è sicuramente la potenza. Non è raro il caso in cui la capacità di potenza dei data center si esaurisca ben prima che venga superata la loro capacità di elaborazione o di memorizzazione. I due fattori che contribuiscono in maniera determinante a questo fenomeno sono la necessità di garantire la ridondanza dell’alimentazione e la modalità di ripartizione della potenza all’interno dei data center: entrambi questi elementi contribuiscono ad un aumento dello spazio occupato ma, soprattutto, lasciando inutilizzate “preziose” fonti di energia che quindi non vengono non sfruttate. Ciò avviene nonostante il fatto che gli attuali server siano molto più efficienti, in termini energetici, rispetto a quelli delle generazioni precedenti e caratterizzati da consumi molto più ridotti nello stato di “idle”, ovvero a riposo. La fornitura di capacità di potenza aggiuntiva a un data center è un’operazione onerosa in termini di tempo e di costi, anche ipotizzando che l’azienda locale che fornisce energia sia in grado di soddisfare questo fabbisogno: secondo un recente report di Idc il fabbisogno di potenza di un data center dovrebbe raddoppiare passando dai 48 GW del 2015 ai 96 GW previsti per il 2021. Dal punto di vista delle spese in conto capitale, il costo legato alle infrastrutture destinate al raffreddamento e all’erogazione di potenza di un data center è secondo solo al costo dei server. Per la natura stessa dei servizi basati su Cloud, la domanda può variare in modo sensibile con una differenza significativa tra la potenza di picco e quella media consumata da un server rack. Di conseguenza, la fornitura della potenza necessaria per soddisfare i picchi della domanda comporterà un sotto-utilizzo della capacità di potenza installata in altri periodi di tempo. Senza dimenticare che alimentatori che operano in presenza di carichi di valore ridotto saranno sempre meno efficienti rispetto ad alimentatori che operano in condizioni di pieno carico. Ovviamente qualsiasi modalità che permetta di livellare il carico di potenza e di sfruttare il surplus disponibile in termini di alimentazione consentirà agli operatori dei data center di soddisfare la richiesta di ulteriori utenti senza dover installare capacità di potenza aggiuntiva. Per quanto riguarda l’efficienza, server e server rack utilizzano architetture di tipo distribuito o Dpa (Distributed power architecture) dove la conversione della potenza da Ac in Dc avviene a diversi livelli. Per un rack, ad esempio, è possibile utilizzare un alimentatore Ac/Dc front-end che fornisce un livello di tensione di 48 Vdc. A livello di singolo server o di scheda, un convertitore Ibc (Intermediate bus converter) trasforma questo valore in una tensione di 12 Vdc, lasciando il compito della conversione ai più bassi valori richiesti dalla Cpu o da altri dispositivi elettronici ai regolatori Pol (Point of load). Questo modello di distribuzione della potenza con valori di tensione elevata contribuisce ad aumentare l’efficienza minimizzando le perdite imputabili alla conversione verso il basso (down-conversion) e permette di evitare le perdite di potenza di natura resistiva che si verificano nei cavi e nelle piste della scheda Pcb, che sono proporzionali alla corrente e alla distanza. L’adozione, avvenuta in tempi abbastanza recenti, di alimentatori a controllo digitale ha consentito l’uso di tecniche Sdp (Software defined power) grazie alle quali è possibile monitorare e controllare il carico di tutti gli alimentatori. Ciò consente di variare i valori delle tensioni intermedie e finali richieste dal carico in modo tale da garantire un funzionamento nel modo più efficiente possibile ai vari stadi di alimentazione. Nonostante ciò le prestazioni dell’hardware hanno praticamente raggiunto i loro limiti: da qui la necessità di individuare altre soluzioni.

L’assegnazione della potenza nei data center

Le architetture degli alimentatori dei data center tradizionali sono progettate per garantire l’alta disponibilità e utilizzano il concetto di ridondanza dell’alimentazione per gestire in maniera efficace i carichi di lavoro “mission-critical”. Nella Fig. 1 è riportato lo schema di una configurazione 2N che garantisce la completa ridondanza previste per i data center con certificazioni Tier 3 o Tier 4. Come si evince dalla stessa figura per un server con doppio cavo di alimentazione una configurazione di questo tipo mette a disposizione un istradamento indipendente per la potenza erogata dalla rete o da generatori di backup con la protezione aggiuntiva garantita dalla presenza di Ups intermedi ridondanti. Anche per i server con singolo cavo di alimentazione sono previsti un generatore di backup e Ups. Un approccio di questo tipo si basa sull’ipotesi, solitamente errata, che tutti i server stanno gestendo compiti di tipo mission-critical e che il carico su ciascuno di essi (e quindi la richiesta di potenza) sia uguale. In realtà una percentuale rilevante dei server (anche fino al 30%) potrebbe essere impegnata nella gestione di carichi di lavoro legati a compiti di test o di sviluppo: ciò significa che la metà della potenza loro assegnata non è in realtà richiesta. In altre parole il 15% della capacità di potenza totale di un data center è bloccata è non può essere utilizzata altrove. L’altro problema è rappresentato dal fatto che, tradizionalmente, la capacità dell’alimentazione è progettata in modo da fornire una potenza atta a supportare i picchi di utilizzo della Cpu. La variabilità del consumo di potenza dei server che una situazione di questo tipo comporta può essere espressa mediante questa semplice equazione di tipo lineare:

Pserver = Pidle + u (Pfull - Pidle )

Dove Pidle è la potenza consumata dal server nello stato di idle and u è il tasso di utilizzo della Cpu. Complici le nuove tecnologie che garantiscono consumi molto bassi nello stato di idle, la differenza tra i consumi in questo stato e in quello di completo utilizzo è aumentata in modo significativo. Questo intervallo aumenta a livello di rack, contribuendo a complicare ulteriormente la pianificazione della capacità sulla base dei tassi di utilizzo della Cpu ipotizzati. La tipologia del carico di lavoro contribuisce ad accentuare la variabilità del consumo di potenza. Secondo studi condotti da Google il rapporto tra la potenza media e la potenza di picco osservata nel caso dei sever che gestiscono le web mail è pari all’89,9%, percentuale che scende al 72,7% nel caso di server che gestiscono attività di ricerca sul web. L’assegnazione della capacità di potenza in un data center basata sul rapporto stimato per le attività di ricerca sul Web potrebbe portare a una percentuale di sotto-utilizzo che può arrivare al 17%. I problemi, sfortunatamente, non si esauriscono qui. Il timore è che i picchi effettivi potrebbero superare quelli previsti con la modellizzazione, con conseguente potenziale sovraccarico del sistema di alimentazione e probabilità che si verifichino interruzioni di potenza. I responsabili della pianificazione, quindi prevedono l’aggiunta di un’ulteriore capacità in modo da disporre di una scorta di sicurezza. Sulla base di quanto esposto non può sorprendere il fatto che l’utilizzo medio nei data center su scala mondiale è inferiore al 40% tenendo semplicemente conto della modellazione della richiesta di picco e delle risorse di buffering aggiuntive: tale percentuale diminuisce nel caso sia prevista la ridondanza.

Sfruttare la capacità di alimentazione sotto-utilizzata

Le problematiche legate al rapporto tra il consumo di potenza medio e di picco sopra esposte di fatto blocca una notevole capacità di potenza. Quando i picchi si verificano in periodi prevedibili e hanno una durata relativamente lunga, i data center solitamente ricorrono a una potenza generata localmente per integrare l’alimentazione di rete, una modalità analoga a quella utilizzata dalle società che erogano l’energia, le quali aumentano e diminuiscono la loro capacità di generare potenza nel corso della giornata per soddisfare la domanda prevista da parte di persone e aziende. Sfortunatamente questa modalità non risolve il problema dei picchi causati da un utilizzo più dinamico della Cpu, caratterizzato da un rapporto tra potenza media e di picco più elevato, di durata inferiore e che si presenta con maggior frequenza. La soluzione in questo caso è rappresentata dall’utilizzo della potenza immagazzinata nelle batterie. Il principio è molto semplice: le batterie forniscono la potenza richiesta quando si verificano i picchi nella domanda e vengono ricaricate durante i periodi di scarso utilizzo. Un approccio di questo tipo è denominato “peak shaving”, ovvero livellamento del picco. In questo caso un server rack che richiederebbe una potenza di 16 kW può essere fatto funzionare con una potenza compresa tra 8 e 10 kW fornita dalla rete. In realtà, se la potenza fornita dalla rete è vincolata per qualche motivo, la potenza richiesta per passare dagli 8 ai 10kW viene generata localmente, mantenendo l’alimentazione di rete a un valore costante di 8kW.

Ottimizzazione attraverso la ridondanza dinamica

Per superare il problema legato all’ipotesi in sostanza errata, menzionata in precedenza, che tutti i data center con certificazioni tier 3 e tier 4 gestiscono carichi di lavoro mission-critical, è possibile procedere all’assegnazione i compiti non critici a server rack a bassa priorità specifici. Ciò consente di installare capacità di server aggiuntiva nel data center fino a un limite che è definito dal massimo carico non critico. Ad esempio in un data center dove il massimo carico di un server rack è 400 kW (per tutti i rack) richiede nominalmente alimentatori doppi da 400 KW (per garantire la completa ridondanza), sarebbe possibile prevedere server rack aggiuntivi a bassa priorità in grado di fornire fino a 100 kW per carichi di lavoro non critici. Quindi nel caso di guasto di uno degli alimentatori da 400 kW, la potenza viene tolta ai server rack a bassa priorità in modo da garantire che i rack mission-critical ricevano la potenza richiesta dall’altro alimentatore da 400 kW. Una gestione “intelligente” del carico consente di sfruttare una capacità di alimentazione ridondante, che non fornisce valore aggiunto, grazie alla quale è possibile incrementare in maniera significativa la capacità, in termini di carico di lavoro, di un data center: nel caso preso in esame è stato possibile incrementare la capacità del 25% senza alcuna potenza aggiuntiva. Ancora una volta, una soluzione hardware/software combinata permette di gestire la potenza in modo dinamico, effettuare il monitoraggio e rilevare un malfunzionamento dell’alimentazione in modo da consentire la commutazione immediata su un alimentatore alternativo e assicurare la continuità di funzionamento dei server rack mission-critical.

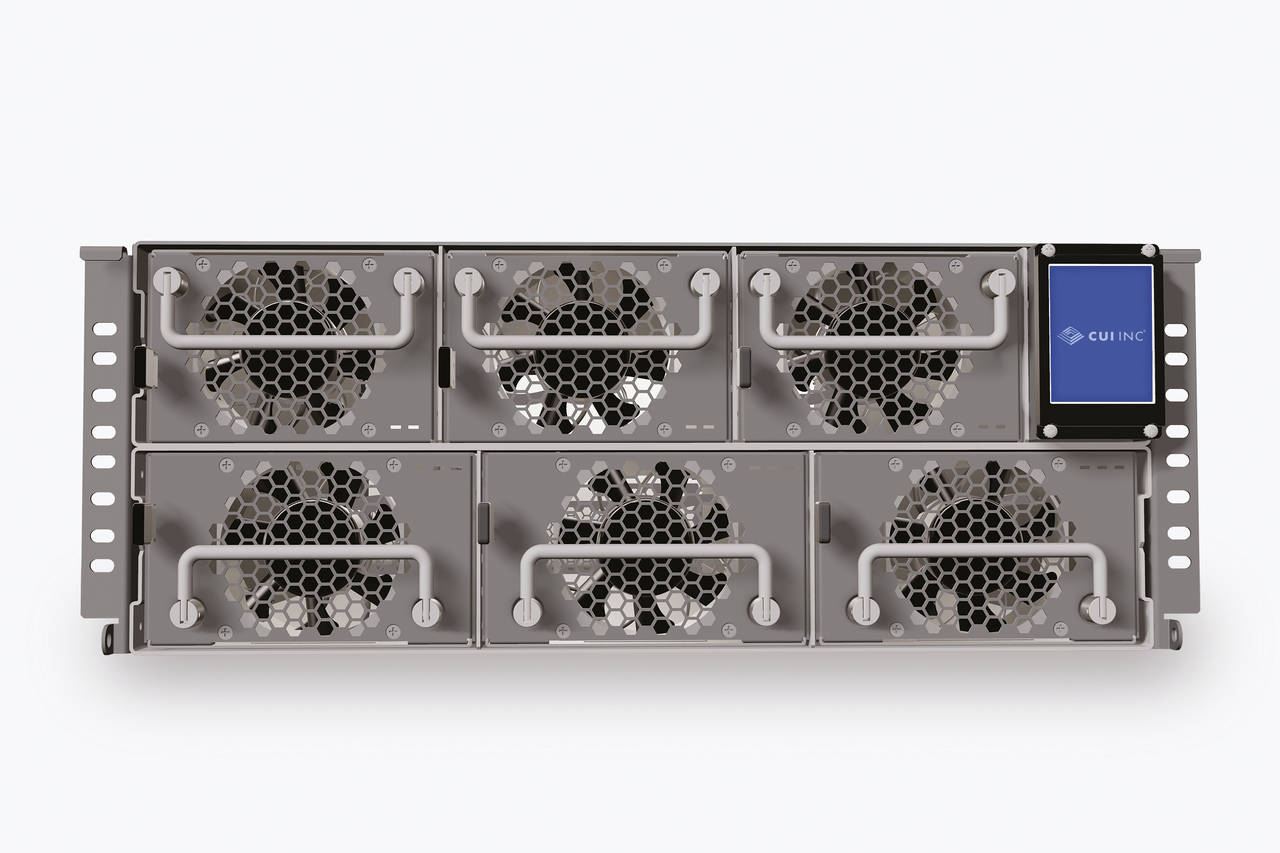

La soluzione Ice ottimizza capacità e prestazioni

Cui in partnership con Virtual Power Systems ha introdotto il concetto di “peak shaving” in una innovativa soluzione Software Defined Power destinata a sistemi informatici. Il sistema Ice (Intelligent control of energy) utilizza una combinazione tra hardware e software per ottimizzare sia l’utilizzo della capacità sia le prestazioni. L’hardware risulta composto da parecchi moduli che comprendono unità di commutazione e sistemi di accumulo a batteria per montaggio a rack che possono essere posizionati in diverse postazioni per il controllo della potenza all’interno di un data center in modo da supportare le decisioni prese dal software circa l’erogazione della potenza stessa. Il software della soluzione Ice prevede un sistema operativo che acquisisce i dati di telemetria provenienti dal sistema stesso e da altri sistemi hardware che compongono l’infrastruttura per consentire il controllo in tempo reale utilizzando gli algoritmi di ottimizzazione della potenza. Per illustrare i vantaggi legati all’utilizzo di questa soluzione, nella Fig. 3 sono riportati i risultati ottenuti installando un sistema Ice di prova in un data center. La figura evidenzia la possibilità di sbloccare 16 kW di potenza da una capacità installata di 80 MW. La spesa in conto capitale legata all’aggiunta di un sistema Ice è pari a ¼ del costo richiesto per l’installazione di un’ulteriore capacità di alimentazione di 16 MW, mentre il ridotto tempo richiesto per svolgere questa operazione ha contribuito alla riduzione delle spese operative.