Big Data, Hadoop, eCommerce, virtualizzazione, cloud computing, Internet delle cose... tutti questi inediti termini sono emersi da una nuova ondata di start-up attive nel settore del software per internet che hanno decretato la riaffermazione delle imprese "dotcom" come motori dell'innovazione tecnologica e come generatrici di profitti. Secondo Cisco, entro il 2020, ben 50 miliardi di dispositivi saranno connessi a Internet, con una crescita spettacolare legata alle applicazioni e ai servizi Web 2.0. Tuttavia, le attività necessarie per supportare questi dispositivi e le loro applicazioni si rifletteranno sulla richiesta di servizi erogati da parte dei datacenter, con un effetto collettivo colossale. Già oggi, la forte pressione sulle risorse di elaborazione, di comunicazione e di archiviazione sta progressivamente sovraccaricando le architetture utilizzate nei datacenter, nei sistemi di storage e nelle reti.

Una domanda in esplosione

Qui di seguito, alcuni esempi di questa esplosione di carichi di elaborazione, che coinvolge i datacenter, illustrano le direzioni di espansione della domanda e la grandezza della sfida.

• Gli utenti degli smartphone scaricano un'ampia selezione di contenuti multimediali complessi sotto forma di video, musica e giochi. Oltre a questi, gli utenti scaricano e utilizzano anche una moltitudine di applicazioni per fare acquisti, cercare ristoranti e informazioni di lavoro, individuare sulle mappe Gps i percorsi per raggiungere le attività individuate. Tutte queste richieste di servizi wireless si fondono sulle dorsali di accesso ai datacenter che in tutto il mondo supportano i motori di ricerca e le piattaforme shopping online.

• I servizi cloud sono evoluti ben oltre il semplice supporto per i giochi Mmo su piattaforme mobili, Pc e consolle: oggi, tali servizi interessano la fornitura di dati e applicazioni sia per i consumatori sia per i clienti aziendali, così come il supporto di applicazioni che richiedono una bassa latenza e prestazioni in tempo reale.

• Le basi di dati, siano esse relazionali, object-based, o Xml, continuano a espandersi in termini di dimensioni e complessità per sostenere non solo la crescita delle transazioni finanziarie online (depositi, prelievi, acquisti di strumenti bancari, e-commerce, pagamenti, trasferimenti, ecc.), ma anche il traffico dei motori di ricerca, dei social media, degli streaming A/V, delle simulazioni di R&S per gli sviluppi di prodotto, della modellazione finanziaria, dell'accesso ai documenti e così via.

• Negli anni 70 e 80, Federal Express ha aperto la strada per una rapida e redditizia distribuzione di piccole spedizioni ai consumatori e alle imprese; nel 1990 Amazon ha rivoluzionato il tradizionale modello di vendita consumer evolvendo da libreria online a emporio digitale. Queste lezioni sono state ormai fatte proprie dai rivenditori di tutto il mondo, i quali stanno riducendo o eliminando il loro spazio fisico di vendita al dettaglio a favore di un modello di business basato sull'e-commerce. A ciò si somma la massiccia espansione del controllo delle transazioni, della gestione degli account e del tracciamento dei processi di acquisto, che inevitabilmente comporta il passaggio a questo nuovo modello di business.

Prerequisiti per i datacenter

Con una gamma così vasta di applicazioni e servizi da supportare, le configurazioni e i modelli di utilizzo dei datacenter aziendali possono variare notevolmente. Le architetture spaziano dalla sala server (piccola come un armadio o grande come un campo da tennis) che ospita le applicazioni di rete aziendali, alle enormi server farm dedicate al commercio elettronico su larga scala, alle applicazioni e ai servizi offerti dagli Isp ai clienti privati e business, e ai servizi di virtualizzazione delle funzioni IT messi a disposizione dai fornitori cloud. Eppure, nonostante le loro notevoli differenze in termini funzionali, di occupazione di superficie, di specifiche software e di profili d'utente, per i datacenter è sempre possibile individuare un insieme comune di prerequisiti che riguardano l'efficacia dell'implementazione e del supporto offerto. Ecco un elenco.

1. Scalabilità - L'architettura del datacenter deve essere sufficientemente flessibile per sostenere la crescita in termini di densità di porte, prestazioni, risorse e applicazioni.

2. Costo-efficacia - Indipendentemente dalle dimensioni dell'impresa, sarà sempre in vigore qualche direttiva aziendale che impone una gestione conservativa dei costi operativi e di manutenzione del datacenter. Per tale motivo, emergono dei requisiti contraddittori tra le esigenze di espandibilità e la necessità di preservare l'investimento esistente; in altre parole, il datacenter deve essere in grado di evolvere "internamente", lasciando apparentemente inalterata le sua struttura. Le considerazioni relative al mantenimento dell'impianto fisico esistente abbracciano tutti gli elementi di generazione precedente, quindi non solo i rack, il cablaggio e la ventilazione, ma anche lo stack software. Le restrizioni sugli spazi e sulla ventilazione impongono inoltre dei vincoli sul consumo di energia. Alla fine, tutti questi requisiti si sommano determinando il Tco (Total cost of ownership) del datacenter.

3. Affidabilità - Tale aspetto include la ridondanza, le funzionalità garantite su richiesta, lo storage di backup, il QoS e il supporto per gli aggiornamenti hardware e software.

4. Prestazioni - Sotto tutti i profili, compresa la velocità pura, le porte e il contenimento delle latenze.

5. Protezione di tutti i dati sensibili - comprese le informazioni personali e riservate dei singoli individui e dei clienti aziendali, delle transazioni di commercio elettronico, di una moltitudine di operazioni finanziarie, e di qualsiasi proprietà intellettuale specifica di un'impresa (informazioni di prodotto, R&s, ecc.).

6. Accesso - Possibilità di accedere attraverso una profusione di dispositivi cablati e wireless con dati, protocolli di comunicazione e requisiti prestazionali differenti.

Funzionalità e silicio

Tutte queste macro esigenze, inevitabilmente, comportano un insieme fondamentale di funzionalità che si concretizzano a livello di silicio. Le implicazioni che determinano l'efficacia dei chip nel contesto di un datacenter sono estreme poiché i requisiti sono spesso complessi e in antagonismo tra loro. Un SoC progettato per il segmento dei datacenter affronta un mercato frammentato, costituito principalmente da impianti esistenti, e che impone una serie di specifiche hanno un effetto che scoraggiante. Tra queste, si evidenziano:

elevata larghezza di banda; basso consumo; costi contenuti; velocità multi-gigabit e una vasta gamma di configurazioni di porte individuali; conformità con standard Lan di generazione precedente, attuali ed emergenti; supporto di memoria ad alte prestazioni; significativa personalizzazione di ogni applicazione. In prospettiva, tutto ciò rende evidente come nel segmento dei datacenter i SoC convenzionali rappresentino una scelta di forte compromesso. Nonostante i tradizionali vantaggi "3P" (potenza, prestazioni e prezzo) garantiti dai SoC in segmenti di mercato più uniformi, la natura frammentaria del mercato dei datacenter rende impossibile un approccio standardizzato. Le diverse esigenze funzionali imposte dai moderni data center - e-commerce, servizi cloud, Rdbms, accessi interni ed esterni provenienti da una vasta gamma di sistemi informatici, dispositivi di sicurezza e sorveglianza, e così via - mettono in evidenza come ogni architettura di datacenter sia sostanzialmente unica. Così, la matrice fissa di risorse offerte da un SoC/Assp standardizzato è probabile che sia sufficiente solo per una percentuale molto limitata di applicazioni. Trasferire le carenze dell'hardware sullo stack software può portare a soluzioni artificiose che costringono a compromessi dolorosi e che talvolta sono insostenibili dalla scheda o dal blade che utilizza il SoC. In un mercato caratterizzato da mole così elevata di variabili e di vincoli applicativi come quello dei datacenter, un approccio SoC/Assp tende ad essere una scelta secondaria. Le soluzioni basate sugli Fpga tradizionali soffrono di un insieme di carenze differente. Le funzioni di protocollo Lan devono essere istanziate come blocchi soft nella matrice programmabile.

Ciò si traduce in una cascata di effetti negativi a livello di progetto:

• emulare blocchi di circuiti standard implica grandi quantità di risorse programmabili;

• gli sviluppatori di sistema sono costretti a utilizzare dispositivi programmabili più grandi e più costosi al fine di poter disporre di risorse sufficienti per la personalizzazione;

• Fpga più grandi consumano più energia e possono avere conseguenze pesanti sul flusso di ventilazione e sui requisiti di raffreddamento a livello di schede e di blade;

• poiché i progetti più grandi richiedono più tempo, più risorse e più fatica per finalizzare i processi di chiusura, di verifica e di test, i cicli di sviluppo si allungano di conseguenza.

Tutto ciò rende palese come sia i SoC/Assp sia le soluzioni Fpga generiche costringano gli sviluppatori ad accettare compromessi progettuali che condizionano i loro sistemi. Un chip che impone modifiche di progettazione fondamentali e limitazioni importanti a livello di sistema è un chip non adatto allo scopo. Ciò che serve oggi non è un approccio che dipenda da chip sviluppati per risolvere i problemi degli anni '90, bensì una proposta che garantisca una soluzione specificamente progettata e dotata di funzionalità su misura per i sistemi del 21° secolo. Per una soluzione basata su chip non è sufficiente offrire un insieme fisso di funzioni ottimizzate in termini di potenza, prestazioni e costi. Tantomeno, non è neanche possibile che il chip sia un dispositivo programmabile adattabile a qualsiasi applicazione a costo però di compromessi di consumo, costo, velocità, larghezza di banda e tempi di progettazione. I SoC del 21° secolo devono essere delle soluzioni sia ottimizzate in termini di "3P", sia altamente flessibili e configurabili.

Fpga per applicazioni ad elevata larghezza di banda

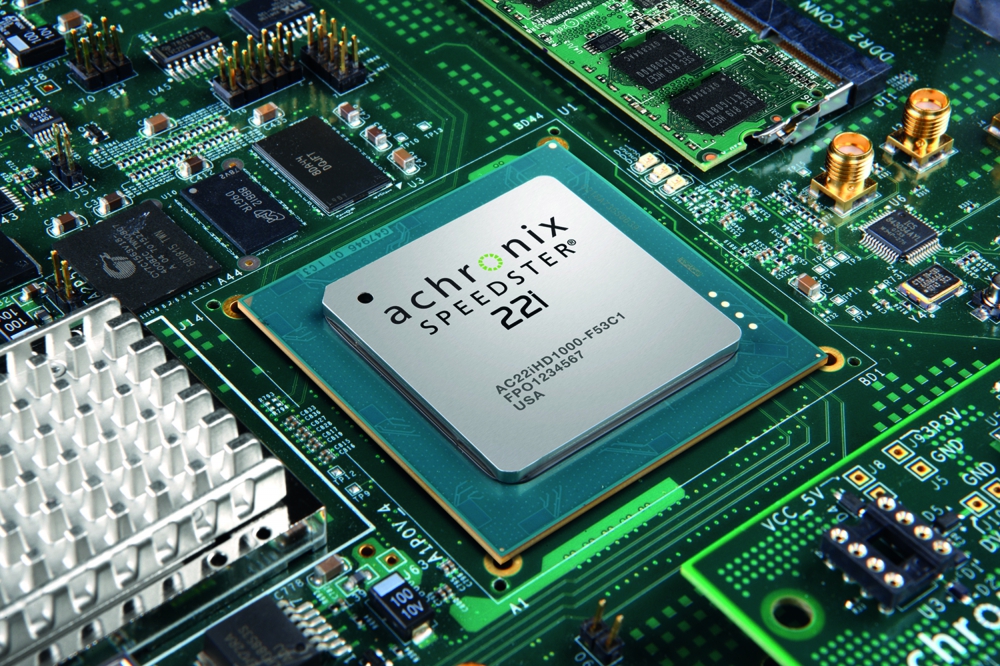

La linea di prodotti 22i Speedster proposta da Achronix mette a disposizione una famiglia di Fpga con hard IP embedded dedicata alle applicazioni ad elevata larghezza di banda. La linea è stata sviluppata per soddisfare il mix unico di requisiti di funzionalità e di configurabilità imposto dal mercato dei data center. Le risorse per garantire flessibilità e configurabilità sono offerte da una struttura programmabile sincrona dotata di un massimo di 1,1M Lut a 4 ingressi, di 145 MB di Sram locale e di vari canali SerDes da 12,75 Gbps, impostabili per supportare una vasta gamma di protocolli di connettività. I vantaggi 3P (prestazioni, potenza e prezzo) tradizionalmente offerti da SoC/Assp sono conseguibili attraverso blocchi hard IP embedded dedicati alle comunicazioni Mac 10/40/100G Ethernet, Llc Interlaken a 100G e Pci 1/2/3, nonché al controllo Ddr3. Questi blocchi hard IP sono precertificati, evitando la necessità di effettuare processi di chiusura temporale e di verifica lunghi e complessi. La scelta del nodo di processo è un fattore importante. Il processo da 22 nm di Intel e la tecnologia FinFet Tri-Gate garantiscono un aumento di velocità del 20% e un consumo inferiore del 50% rispetto agli Fpga da 28nm. Sempre rispetto agli Fpga generici, nelle applicazioni data center i SoC programmabili Speedster offrono anche consumi, costi e tempi di progettazione, ridotti della metà. La versione HD1000, che rappresenta la versione di fascia media della famiglia 22i, è attualmente proposta con 700k Lut programmabili, 86 MB di Sram e 64 canali SerDes a 12,75 Gbps. I core IP principali includono due Mac 10/40/100G Ethernet, due Lcc 100G Interlaken, due Lcc Pci Express e sei controller Ddr2/3. La versione HD1000 è disponibile in package Fbga da 1936 a 2601 pin.

Soluzioni per il futuro

I mercati dei chip sia tradizionali sia di nuova generazione stanno diventando sempre più frammentati. Gli Oem cercano infatti un vantaggio competitivo attraverso una diversificazione dei prodotti che permetta loro di occupare nicchie sempre più specializzate. La crescita dinamica del mercato dei data center, guidata dalle esigenze dell'utente finale, è un indicatore importante di questa tendenza. Qui, gli Oem competono ferocemente per proporre soluzioni che soddisfino le esigenze di prestazioni e di carico all'interno di uno spazio di distribuzione fisica limitata. Il futuro della microelettronica sta nel trovare soluzioni convincenti per questi mercati frammentati: l'approccio tradizionale e datato, basato su Assp/SoC corredati da funzioni fisse o su Fpga generici, sono superati e non sono più efficaci. Le future soluzioni a chip devono essere attentamente calibrate per indirizzare segmenti di mercato mirati, garantendo una combinazione intelligente tra funzioni fisse e tecnologia configurabile. Questo permette di soddisfare i requisiti granulari di nicchie sistemistiche emergenti. La famiglia di Fpga Speedster 22i è la prima offerta di silicio reale a varcare questa soglia.