Nella corsa globale per il dominio dell’intelligenza artificiale, il ruolo dell’hardware è sempre più strategico: dalle GPU evolute ai chip neuromorfici, così si costruisce il futuro della reasoning AI

L’intelligenza artificiale (AI) apprende dai dati e fornisce risposte che costituiscono un supporto sempre più cruciale nei processi decisionali e nella trasformazione del modello di business delle varie organizzazioni. Le capacità della AI continuano a evolversi, ma richiedono crescente potenza di calcolo. Naturalmente, la capacità evolutiva della componente software, quindi dei modelli AI, rimane essenziale: ma ora il ruolo centrale dell’hardware sta sempre più emergendo in primo piano, e spostando la pressione sui team di ricerca e sviluppo che hanno il compito di esplorare nuove architetture e innovare i chip, i semiconduttori, e la componente infrastrutturale che consente ai modelli AI di funzionare. Ora è la capacità d’innovazione dell’hardware che limita i progressi negli algoritmi di AI generativa (GenAI), e la loro transizione verso forme ancora più evolute di intelligenza artificiale. Molto dipenderà da quali avanzamenti saranno raggiunti nello sviluppo di acceleratori AI e dispositivi basilari per il supporto dei modelli, che oggi includono soprattutto GPU (graphics processing unit) e TPU (tensor processing unit), ma anche NPU (neural processing unit), ASIC (applicationspecific integrated circuit), FPGA (field programmable gate array), e altri dispositivi di nuova concezione, come i chip neuromorfici, ancora sostanzialmente in fase di ricerca e sviluppo avanzato.

Nella gara mondiale per il dominio dei semiconduttori e dei chip AI concorrono da tempo attori come Nvidia, AMD, Intel, Google, AWS, Huawei, ma lo scenario sta cambiando, per effetto delle mosse strategiche di alcune società, che vanno anche nella direzione di ridurre la dipendenza dagli acceleratori AI di fornitori esterni: ad esempio, negli ultimi due anni Microsoft ha cominciato a muoversi direttamente nell’hardware, annunciando nel 2023 i suoi primi chip AI proprietari sviluppati interamente, Maia e Cobalt. Ed ora anche OpenAI, secondo quanto riportato dal Financial Times i primi di settembre, si prepara a produrre il suo primo chip AI nel 2026, in collaborazione con il gigante statunitense dei semiconduttori Broadcom, per il quale l’accordo di partnership vale 10 miliardi di dollari. Insomma, la posta in gioco è molto alta perché, nella competizione sulla AI, la qualità e la potenza dei chip avrà un peso determinante nel supporto dei modelli di nuova generazione. Questi ultimi potranno superare i modelli attuali se sapranno fare la differenza, e dimostrarsi sempre più affidabili anche nell’elaborazione di ragionamenti complessi.

Oltre la AI generativa

Dopo il lungo clamore mediatico che ha segnato l’avvento e la diffusione della AI generativa, ora sempre più l’accento è posto sulle funzionalità della AI agentica, e soprattutto sulla “reasoning AI”, o AI di ragionamento. L’obiettivo è far evolvere i modelli verso forme di ragionamento più simili ai processi cognitivi che regolano la mente umana. Un’ambizione non da poco, certamente anche dal punto di vista computazionale, considerando quanto dichiarato lo scorso febbraio dall’amministratore delegato di Nvidia, Jensen Huang, durante un’intervista della televisione americana Cnbc. L’intelligenza artificiale di nuova generazione, ha spiegato Huang, richiederà una potenza di calcolo 100 volte superiore rispetto ai modelli precedenti, a causa dell’introduzione di nuovi approcci di ragionamento, che riflettono, passo dopo passo, sul modo migliore per rispondere alle domande.

Potenza di calcolo, quanta ne occorre nell’era della reasoning AI

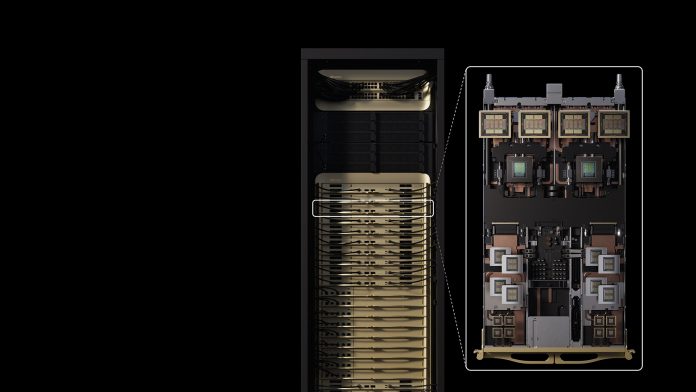

Giusto per dare un’idea della capacità computazionale richiesta dai modelli di ultima generazione, si può fare riferimento alle caratteristiche e alle specifiche tecniche di un chip come la GPU Rubin CPX, annunciata in settembre da Nvidia, all’AI Infra Summit 2025 di Santa Clara, California. Rubin CPX, la cui disponibilità è prevista alla fine del 2026, è pensata per accelerare la reasoning AI, e – dichiara Nvidia – appartiene a una nuova classe di GPU appositamente progettate per l’elaborazione di contesti di grandi dimensioni (massive-context). In altre parole, permette ai modelli linguistici di grandi dimensioni LLM (large language model) di ‘ragionare’ su milioni di token contemporaneamente: ad esempio elaborare milioni di token di codice software, e video generativi con una velocità ed efficienza all’avanguardia.

Per inciso, quando si parla di dimensione, di “lunghezza del contesto” (context length), o di “finestra contestuale” (context window), si intende in sostanza la memoria di lavoro del modello LLM, ossia il numero massimo di token (unità di testo) che è in grado di elaborare e “ricordare” contemporaneamente per generare una risposta. Questa evoluta capacità di contestualizzazione risulta fondamentale per implementare un sistema di reasoning AI, come quello, ad esempio, basato su un agente AI che deve analizzare un intero progetto prima di scrivere una riga di codice. In linea di massima, una finestra contestuale più ampia tende ad aumentare la precisione e a ridurre le ‘allucinazioni’ nelle risposte fornite da un LLM. Ciò aiuta a migliorare l’affidabilità del sistema di intelligenza artificiale, che alla fine è l’obiettivo centrale di queste innovazioni nelle tecniche di ragionamento.

La GPU Rubin CPX è basata su architettura Rubin di Nvidia, annunciata al Computex2024 di Taipei. L’architettura Rubin è realizzata con processo produttivo a 3 nm (nanometri) di TSMC (Taiwan Semiconductor Manufacturing Company) e rappresenta il successore della piattaforma Blackwell. Rubin CPX, dichiara Nvidia, fornisce fino a 30 petaFLOPs di potenza di calcolo con precisione NVFP4, e 128 GB di memoria GDDR7, per accelerare i carichi di lavoro context-based più impegnativi. Fornisce inoltre capacità di attenzione tre volte più rapide rispetto ai sistemi NVIDIA GB300 NVL72, aumentando l’abilità di un modello di intelligenza artificiale di elaborare sequenze di contesto più lunghe senza un calo di velocità. Allo scopo di ridurre la complessità di fabbricazione e il costo, Rubin CPX adotta un design basato su die monolitico, che, nonostante le potenti risorse di calcolo integrate, è ottimizzato per fornire prestazioni ed efficienza energetica molto elevate per le attività di inferenza. Rubin CPX, aggiunge Nvidia, lavora in sinergia con le CPU (central processing unit) Vera e le GPU Rubin all’interno della nuova piattaforma Nvidia Vera Rubin NVL144 CPX. Questo sistema Nvidia MGX integrato racchiude 8 exaflop di potenza di calcolo AI, per fornire prestazioni AI 7,5 volte superiori rispetto ai sistemi NVIDIA GB300 NVL72, oltre a 100 TB di memoria veloce e 1,7 petabyte al secondo di larghezza di banda di memoria in un unico rack.

Mitigare le ‘allucinazioni’ della GenAI

Sviluppare modelli in grado di elaborare un ragionamento più solido, basato anche sui principi della logica formale, è una tappa fondamentale per mitigare le limitazioni degli attuali modelli LLM, e aumentare l’affidabilità delle risposte fornite dalla AI generativa, immancabilmente ben articolate nella forma, ma talvolta imprecise, plausibili solo in apparenza, o evidentemente false. Queste ‘allucinazioni’ creano spesso nell’utente l’illusione di interagire con “un sistema che produce contenuti che sembrano conoscenza” spiega in un post su Linkedin Walter Quattrociocchi, professore ordinario di informatica alla Sapienza Università di Roma. In realtà, i modelli attuali sono fondamentalmente motori statistici di previsione del linguaggio, non modelli cognitivi. Eccellono nel generare risposte grammaticalmente e stilisticamente coerenti alle domande poste dall’utente, combinando pattern linguistici, ma senza possedere consapevolezza o comprensione intrinseca del loro significato o della loro veridicità. Di conseguenza, le allucinazioni sono un difetto connaturato negli LLM, il limite che impedisce di ritenere la GenAI affidabile nell’automazione di compiti complessi senza una supervisione umana.

Come si affronta il ‘dilemma della fiducia’

Affinché il mercato dei dati e dell’intelligenza artificiale abbia successo, le imprese sono chiamate a superare il ‘dilemma della fiducia’ nella AI, cosa che ora diventa un imperativo categorico: così definisce il problema della attendibilità della AI una ricerca della società di analisi e consulenza IDC pubblicata a settembre 2025, e commissionata da SAS, azienda globale di primo piano nella AI e nei dati. Nonostante l’evidenza che la GenAI possa essere soggetta a errori, indica la ricerca, le organizzazioni hanno più fiducia in questa tecnologia che in altri tipi di AI, incluso l’apprendimento automatico (ML).

In altre parole, gli utenti tendono a riporre eccessiva fiducia nelle forme di AI che percepiscono più familiari e dotate di una interattività simile a quella umana, indipendentemente dalla loro reale affidabilità o precisione. Superare il dilemma della fiducia è della massima importanza, si chiarisce nella ricerca, perché, solo negli ultimi due anni, la AI generativa ha già eclissato l’uso della AI tradizionale. E con il rapido avanzamento del mercato verso la AI agentica, l’impatto sul processo decisionale sarà pervasivo, “spesso nascosto dietro l’automazione e l’integrazione”. Allora che fare? Per conquistare la fiducia nella AI, sono suggeriti tre punti chiave da perseguire: primo, il settore dell’intelligenza artificiale deve aumentare il tasso di successo delle implementazioni. Secondo, le persone devono saper esaminare in maniera critica i risultati generati dalla AI. E, terzo, chi nell’organizzazione detiene la leadership deve responsabilizzare i lavoratori e metterli nelle condizioni per valorizzare al meglio il potenziale dell’intelligenza artificiale.

Il percorso verso una reasoning AI

Dopo gli algoritmi di apprendimento automatico (ML), l’evoluzione della AI ha raggiunto grande popolarità con l’avvento della AI generativa, che ha dimostrato capacità di conversazione, di creazione di codice, di elaborazione di contenuti testuali originali e coerenti. Successivamente, con modelli come DALL-E 3 e Sora, la AI generativa è diventata multimodale, ed ha acquisito una maggior comprensione del contesto, imitando l’abilità del cervello umano di integrare le informazioni raccolte da sensi differenti. Così la AI è arrivata a elaborare e fondere informazioni ricavate non solo da testi, ma anche da immagini, video, contenuti audio, dati acquisiti da sensori e quant’altro. L’ulteriore passaggio si sta compiendo con la diffusione della AI ‘agentica’, che utilizza agenti autonomi per portare a termine compiti complessi, e si può considerare una tipologia avanzata di AI di ragionamento, o meglio un’applicazione pratica in grado di sfruttare intensamente il ragionamento. E ora, attraverso la reasoning AI, l’obiettivo è andare oltre il semplice riconoscimento di schemi (pattern recognition), e fornire al modello l’abilità di eseguire deduzioni, inferenze logiche, di pianificare e risolvere problemi in maniera strutturata, riducendo le allucinazioni.

Sebbene la reasoning AI possa essere implementata anche con modelli neurali-statistici (LLM), applicando, ad esempio, tecniche come la ‘chain-of-thought’ (CoT), la ricerca sta orientandosi attivamente verso la AI ibrida, o AI neurosimbolica, con l’obiettivo di massimizzare l’affidabilità delle risposte, la loro verificabilità, e di ridurre le allucinazioni in cui l’intelligenza artificiale può incorrere.

L’intelligenza artificiale neurosimbolica è un approccio che punta a unire “il meglio dei due mondi”, integrando due paradigmi dell’intelligenza artificiale tradizionalmente separati, ossia la AI neurale (deep learning - DL) e la AI simbolica (good old-fashionedAI - GOFAI). La prima eccelle nel riconoscimento di pattern e nell’apprendimento da grandi volumi di dati, ma è incline alle allucinazioni, mentre la seconda, basandosi su regole, logica e ragionamento formale, costituisce un motore di ragionamento in grado di verificare le risposte in base a un insieme di principi logici predefiniti, riducendo la probabilità di generare informazioni false o contraddittorie.

Nuovi approcci per i semiconduttori dedicati alla reasoning AI

Supportare la reasoning AI avanzata è una sfida che richiede la creazione di semiconduttori dotati di potenza di calcolo sempre maggiore, ma anche lo sviluppo di chip con architetture innovative: questo perché molti degli attuali chip, inclusi gli acceleratori per GenAI con elaborazione parallela massiva, al netto di vari miglioramenti e ottimizzazioni, sono progettati seguendo uno schema che ancora riflette l’architettura di von Neumann, in cui la memoria e l’unità di calcolo (CPU, GPU) sono nettamente separate. Ciò, nelle applicazioni di calcolo per la AI, si trasforma in un collo di bottiglia in fase di trasferimento dei dati tra memoria e processore, rallentando il ragionamento complesso in tempo reale, e consumando molta energia.

Ecco perché, allo scopo di accelerare la velocità di ragionamento e contenere i consumi, i team R&D stanno attivamente muovendosi verso approcci non-von Neumann. Esempi possono essere le architetture di Cerebras WSE (Wafer-Scale Engine) o SambaNova RDU (Reconfigurable Dataflow Unit).

Altri approcci alternativi che l’industria dei semiconduttori sta esplorando per potenziare la reasoning AI includono architetture come il neuromorphic computing, che si ispira al cervello umano per ottenere maggiore efficienza e capacità di ragionamento. Tra gli esempi di chip neuromorfici si possono ricordare il processore neuromorfico sperimentale Loihi 2 di Intel, o il chip TrueNorth, sviluppato dalla ricerca IBM. In queste architetture l’hardware fisico punta a replicare la struttura e il funzionamento dei neuroni biologici, implementando artificialmente neuroni e sinapsi tramite varie tipologie di circuiti integrati. I processi di elaborazione dati avvengono in maniera altamente parallela e distribuita. Inoltre, funzionando sui principi delle reti neurali spiking (SNN - spiking neural network) ogni neurone artificiale si attiva solo quando necessario, migliorando notevolmente l’efficienza energetica del sistema.