Portare i modelli di intelligenza artificiale e l’inferenza AI in qualunque ambiente IT è il vantaggio che può fornire una piattaforma dati ibrida come Cloudera. All’evento Evolve25 la casa californiana ha presentato le ultime funzionalità per facilitare il deployment dei workload AI nei data center aziendali, ottimizzando anche l’uso dei chip

In un mondo economico e industriale dominato dai dati, le piattaforme dati rappresentano oggi il motore primario per la crescita e la competitività di un’organizzazione. Tuttavia, nell’era dell’intelligenza artificiale (AI) e dei sistemi distribuiti, questa capacità competitiva può raggiungere il suo massimo potenziale soltanto quando le varie organizzazioni riescono a implementare piattaforme dati ibride. Così si può riassumere uno dei messaggi fondamentali che Cloudera, società globale fornitrice di una piattaforma dati ed AI rivolta soprattutto alle grandi organizzazioni, ha voluto trasmettere ai partecipanti di Evolve25. In ottobre, la serie di eventi mondiali, passando da Singapore, San Paolo, New York, Washington D.C., Dubai, ha fatto tappa anche a Londra: obiettivo riunire tutti gli attori del comparto per annunciare le principali innovazioni di prodotto ed esplorare le best practice che consentono di unificare, gestire e sfruttare i dati al meglio, attivando prese decisionali in tempo reale e trasformando l’efficienza delle operazioni aziendali.

Portare la AI dove sono i dati

Il filo conduttore di fondo e ‘mantra’ dell’evento è stato “bringing AI to your data – anywhere”, a sottolineare che la AI deve essere portata verso i dati, e non viceversa. Si è parlato di come dati ed AI possono rivoluzionare organizzazioni aziendali e settori industriali, di strategie per potenziare la produttività adottando la AI generativa. Si sono illustrati scenari e prospettive future sull’impatto che l’intelligenza artificiale determinerà nella ridefinzione dei modelli di business.

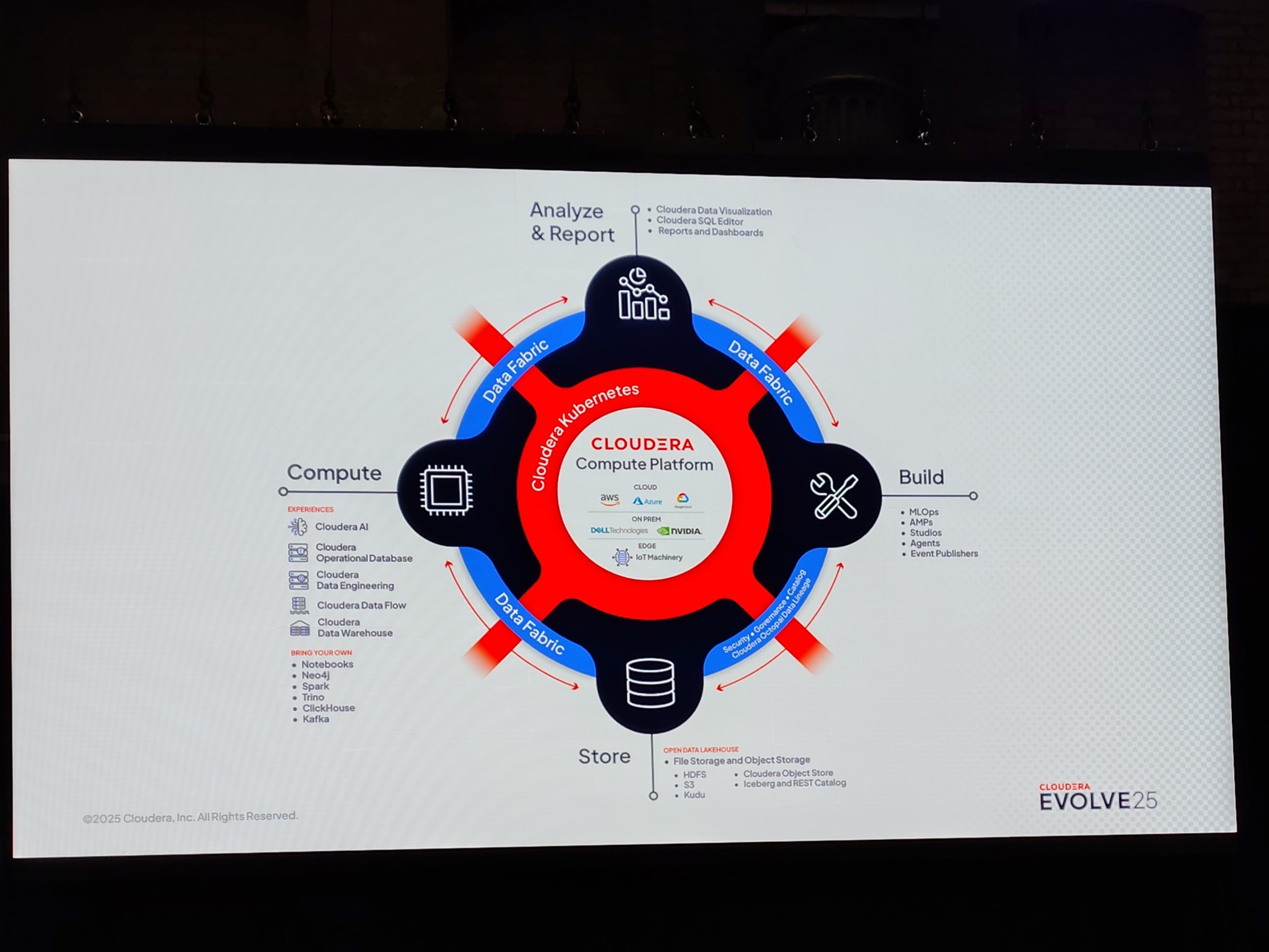

In generale, quando si parla di piattaforma dati ci si riferisce a un sistema tecnologico unificato, in grado di acquisire, archiviare, gestire, governare e rendere accessibili centralmente i dati di un'intera organizzazione. Ma si fa riferimento anche a un sistema capace di analizzare i dati, ed estrarre insight utili, che aiutino le diverse categorie di utenti e profili aziendali a supportare decisioni e applicazioni di business.

Per inciso, con ‘piattaforma dati ibrida’ Cloudera intende in sostanza una piattaforma dati che permette di razionalizzare e massimizzare la gestione, la governance e il valore dei dati, indipendentemente dal fatto che vengano elaborati nel cloud, nel data center on-premise, o nella rete periferica (edge). Nello stesso tempo, sul versante hardware, una piattaforma dati moderna richiede di essere supportata da chip specializzati, soprattutto considerando il fatto che le CPU (central processing unit) ‘general-purpose’ tradizionali oggi non sono più sufficienti per gestire il volume e la complessità degli attuali carichi di lavoro analitici. Serve anche software con la capacità di ottimizzare le prestazioni delle GPU (graphics processing unit) e dei modelli di intelligenza artificiale nei differenti ambienti di elaborazione.

Workload AI in ambienti ibridi, una suite di applicazioni per gestirli

Sempre nel contesto di potenziamento e razionalizzazione dell’infrastruttura hardware esistente nelle differenti organizzazioni, e in linea con la strategia tecnologica di portare la capacità di calcolo e accelerazione dei carichi di lavoro generati dai modelli AI là dove serve, ovvero il più vicino possibile ai dati dell’utente, a Evolve25 viene annunciata l’introduzione dei Cloudera Data Services 1.5.5. Tale soluzione, dichiara Cloudera, consiste in una potente suite di applicazioni containerizzate per gestire carichi di lavoro di data engineering, data warehousing e intelligenza artificiale: queste applicazioni, essendo incapsulate e distribuite in container software, diventano portabili ed eseguibili in modo sicuro all’interno del data center aziendale.

Attraverso tali funzionalità, la release 1.5.5 dei Cloudera Data Services si propone di semplificare per le imprese il compito di dispiegare ed eseguire carichi di lavoro di intelligenza artificiale in ambienti IT ibridi. Storicamente, ricorda Cloudera, far girare workload AI in questi ambienti, ad esempio infrastrutture cloud e data center on-premise, ha sempre significato dover implementare complesse, e non supportate, soluzioni ‘fai da te’. Quando viene a mancare una piattaforma dati coerente e unificata, le funzionalità cruciali per il ciclo di vita completo (end-to-end) dell’intelligenza artificiale restano isolate in luoghi diversi, e ciò costringe le squadre di tecnici dell’organizzazione IT a colmare manualmente le lacune, attuando opportune integrazioni. Cloudera Data Services 1.5.5 ha l’obiettivo di mutare radicalmente questo scenario, fornendo gli strumenti per accedere ai dati ovunque, e creando un unico, fluido ciclo di vita dell’intelligenza artificiale su una sola piattaforma dati ibrida. In questo modo diventa possibile innovare con maggior rapidità, evitando di dover gestire processi frammentari, o di compromettere i meccanismi di sicurezza e controllo già esistenti nell’infrastruttura.

AI privata nel data center aziendale: i benefici di Cloudera

L’obiettivo di Cloudera, con i propri Data Services, è fornire un’alternativa alle imprese che, per realizzare i propri progetti di intelligenza artificiale aziendale, talvolta si trovano a dover prendere la decisione di spostare i loro dati proprietari più preziosi e sensibili verso modelli AI esterni, ospitati nel cloud, con tutti i rischi che ciò può comportare. Tra questi, si devono fronteggiare possibili vulnerabilità di sicurezza, ma anche affrontare costi potenzialmente imprevedibili, che l’adozione del cloud su larga scala può generare. L’idea di Cloudera, invece, come accennato, è portare in maniera sicura la AI generativa, e la sua potenza di elaborazione, dove i dati già risiedono, e in particolare all’interno dei data center aziendali, su cui le varie organizzazioni hanno largamente investito nel corso del tempo.

Con la release 1.5.5 dei Data Services diventa possibile innovare e implementare una AI privata aziendale direttamente dentro il data center, dove i dati restano protetti, e difesi dal firewall aziendale, senza correre nessun rischio di esposizione di dati sensibili o proprietà intellettuale verso l’esterno. Le funzionalità della versione 1.5.5 forniscono all’utente un’esperienza ‘cloud-like’, combinando i vantaggi di agilità, elasticità, e scalabilità automatica del cloud in rapporto ai diversi workload, con la sicurezza e la capacità di controllo disponibili nel data center on-prem. I servizi dati della release 1.5.5, aggiunge Cloudera, consentono di migliorare notevolmente anche l’efficienza, in quanto si può far affidamento su un’architettura dati moderna, in cui la scalabilità delle risorse di calcolo e di storage può avvenire in maniera indipendente, in modo da ridurre i costi infrastrutturali e ottimizzare l’utilizzo delle risorse IT.

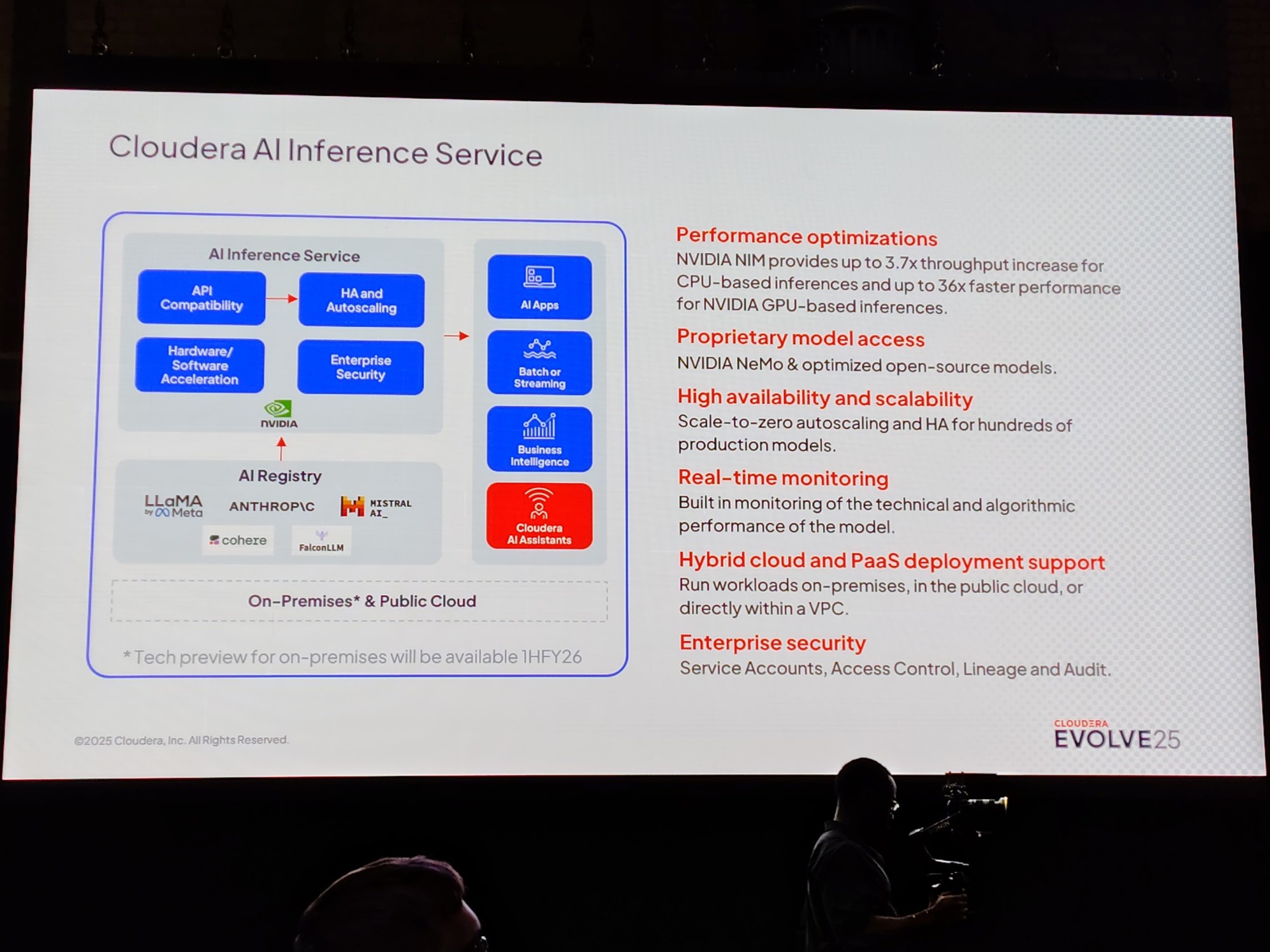

AI Inference service: come ottimizza l’uso delle GPU

In particolare, un aspetto importante sottolineato nella release 1.5.5 è l’introduzione del supporto on-premise per il servizio Cloudera AI Inference service, accelerato da Nvidia, e di Cloudera AI Studios, una suite completa di strumenti low-code progettata per semplificare lo sviluppo, la personalizzazione e l’implementazione di soluzioni di AI generativa (GenAI) all’interno delle aziende. Prima della pubblicazione della release 1.5.5, infatti, tali offerte erano disponibili e utilizzabili soltanto nell’infrastruttura cloud. Attraverso il supporto on-premise, AI Inference service fornisce in sostanza un motore sicuro, e con potenza modulabile, per implementare e gestire in produzione, direttamente all’interno del data center aziendale, i vari modelli AI che un’organizzazione pianifica di sviluppare. Adottando AI Inference service è quindi possibile portare l’applicazione di intelligenza artificiale dove si trovano i dati aziendali, evitando la necessità di migrarli verso l’esterno per l’elaborazione nella nuvola.

AI Inference service è alimentato dai microservizi Nvidia NIM (Nvidia Inference Microservices), che fanno parte della piattaforma software cloud-native Nvidia AI Enterprise. Nel 2024 Cloudera ha infatti espanso la sua collaborazione con Nvidia, integrando i microservizi Nvidia NIM enterprise-grade in Cloudera Machine Learning (CML), un servizio della propria piattaforma dati (CDP) per la gestione di workflow di AI e apprendimento automatico (ML). Ogni microservizio NIM è un container software che incapsula il modello di intelligenza artificiale specifico, assieme a tutte le dipendenze, all’ambiente di runtime e ai framework necessari per l’inferenza. Ciascun container è configurato per utilizzare le risorse GPU disponibili sull’host, che, a seconda dei casi, può essere un server fisico oppure una macchina virtuale su cui è in esecuzione il container. I container NIM sono per loro natura portabili, distribuibili ed eseguibili sull’infrastruttura scelta dall’utente: in funzione delle esigenze aziendali, questa di volta in volta è individuabile in un cloud pubblico, in un data center privato o nell’infrastruttura edge. Le applicazioni o gli utenti accedono in modalità remota al modello AI tramite una API (application programming interface) standard fornita dal container NIM.

Come orchestrare le risorse di inferenza AI in ambienti IT ibridi con Cloudera

La piattaforma dati ibrida Cloudera, implementabile e modulabile sia sul cloud pubblico sia nel data center privato, attraverso le funzionalità di AI Inference service è in grado di orchestrare al suo interno i microservizi NIM, specificamente progettati per sfruttare al meglio l’hardware di Nvidia. Ecco come funziona: in sostanza, quando viene effettuata una richiesta di inferenza AI, ad esempio a un modello linguistico di grandi dimensioni (LLM – large language model), il microservizio NIM indirizza l’elaborazione verso le GPU Nvidia esistenti e disponibili nell’infrastruttura dell’impresa utente. Queste GPU possono trovarsi fisicamente installate nell’infrastruttura cloud, sotto forma di istanze GPU fornite da un cloud provider come AWS, Azure o Google Cloud. Oppure, possono essere hardware GPU di proprietà dell’impresa stessa, e trovarsi installate nel suo data center privato on-premise. Ma tali GPU possono anche essere installate in un ambiente ibrido, quindi in entrambe le infrastrutture (cloud e data center on-prem). I microservizi NIM agiscono fondamentalmente come un livello software ottimizzato, che consente di eseguire con efficienza i modelli AI su qualunque infrastruttura dotata di GPU Nvidia, rispondendo al contempo a requisiti di flessibilità, sicurezza dei dati e controllo dei costi.

Data management, servono solide piattaforme dati

Nell’era della AI, implementare una piattaforma dati moderna diventa il prerequisito chiave per sviluppare e addestrare modelli di machine learning e applicazioni di AI generativa. Queste applicazioni, come quelle di manutenzione predittiva, o le applicazioni di segmentazione avanzata dei clienti, dipendono infatti dalla qualità e disponibilità di dati centralizzati. Da questo punto di vista, la AI alza la posta in gioco, sottolinea nel suo intervento a Evolve25 Matt Aslett, research director Data and Analytics di ISG (Information Services Group) - società globale di ricerca e consulenza tecnologica incentrata sull’intelligenza artificiale - perché la AI impone alle organizzazioni di rafforzare le soluzioni e le strategie di data management. Soprattutto, la forma più avanzata di intelligenza artificiale, la cosiddetta “AI agentica”, che coordina agenti AI autonomi in un ambiente dinamico per compiere attività specifiche, richiede spesso l’accesso a dati real-time per massimizzare l’efficacia, e una piattaforma dati di ultima generazione deve essere in grado di soddisfare tale requisito.

Supporto hardware non solo per GPU

A livello hardware, una piattaforma dati ibrida come Cloudera, al pari di altre piattaforme dati cloud-native, tra cui, ad esempio, Databricks o Snowflake, si concentra principalmente sul supporto esplicito alle GPU per gestire i carichi di lavoro AI e l’analisi parallela. Tuttavia, quando viene distribuita su un cloud pubblico, CDP (Cloudera Data Platform) è in grado di supportare indirettamente anche un hardware custom, ovvero i chip AI personalizzati che un cloud provider usa. Questi chip possono essere costituiti da dispositivi ASIC (application specific integrated circuit), come nel caso dell’accordo strategico di collaborazione di recente siglato da Cloudera con AWS (Amazon Web Services), che ha permesso di estendere l’offerta per la AI generativa attraverso l’integrazione dei servizi AWS Trainium. I chip AWS Trainium sono, in effetti, dispositivi ASIC progettati e ottimizzati per un uso specifico. I chip AWS Trainium, dichiara AWS, costituiscono una famiglia di chip AI creati appositamente per l’addestramento dei modelli di machine learning e l’inferenza AI, e puntano a fornire prestazioni elevate riducendo i costi.

L’abilità di supportare hardware eterogeneo diventa un fattore importante nell’attuale fase evolutiva dell’intelligenza artificiale, in cui, oltre alle GPU, stanno trovando spazio di diffusione anche altri chip e acceleratori AI. Le GPU, scrive la società di ricerca e consulenza indipendente IDTechEx, hanno avuto un ruolo fondamentale nella fornitura di capacità computazionale, in qualità di hardware dominante per la gestione dei modelli linguistici di grandi dimensioni (LLM) e dell’AI generativa. Tuttavia, la domanda proveniente dal mercato sta richiedendo risorse di calcolo più efficienti, costi inferiori, prestazioni più elevate, sistemi massicciamente scalabili, inferenze più veloci e capacità di calcolo ‘domain-specific’, creando opportunità di sviluppo per altre tipologie di chip AI. Tali acceleratori AI, come emerge dal rapporto di IDTechEx (“AI Chips for Data Centers and Cloud 2025-2035: Technologies, Market, Forecasts”), includono, oltre alle GPU, anche ASIC custom adottati da hyperscaler e cloud service provider, CPU AI-capable, e altri ASIC per AI, sviluppati sia da startup specializzate in chip AI, sia da grandi fornitori. Il mercato globale dei chip AI, secondo le previsioni di IDTechEx, raggiungerà un valore di 473,2 miliardi di dollari entro il 2035, crescendo con un CAGR (tasso annuo di crescita composto) pari al 7,2% nel periodo della previsione (2025 – 2035).