L’enorme complesso di data center sta sorgendo a Sines, Portogallo, e promette di fornire energia e potenza di calcolo sufficienti per supportare workload AI, HPC e cloud, soddisfacendo al contempo requisiti di efficienza energetica e sostenibilità. Nel progetto, Start Campus collabora con il partner tecnologico Schneider Electric.

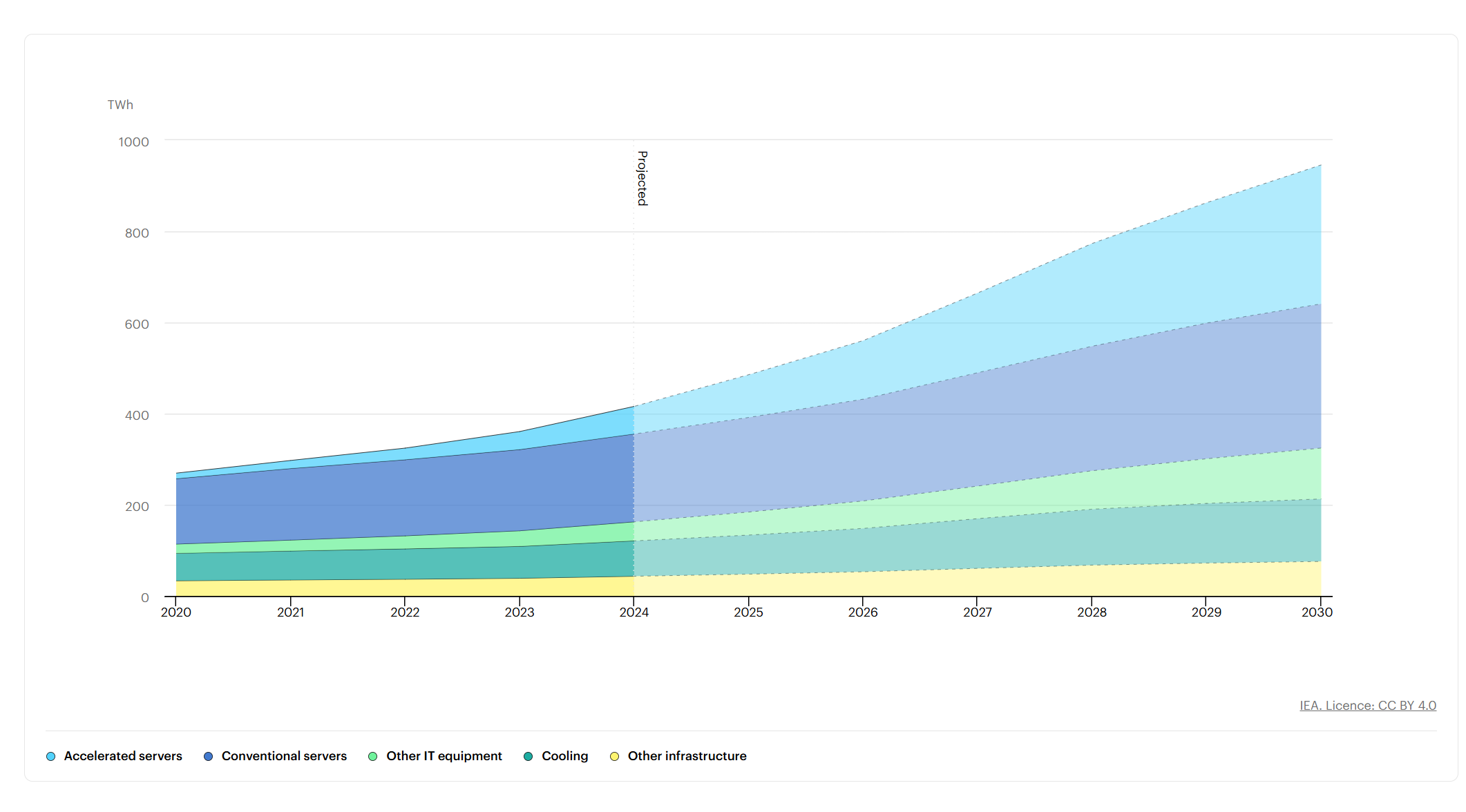

Il consumo di energia dei data center continuerà ad aumentare nei prossimi anni. Sarà guidato soprattutto dall’incremento della domanda di energia richiesta per alimentare la capacità computazionale che supporta i carichi di lavoro (workload) generati dalle applicazioni di intelligenza artificiale (AI). Nel 2024, secondo il rapporto Energy and AI, pubblicato dall’Agenzia internazionale per l’energia (IEA), i data center hanno rappresentato circa l’1,5% del consumo mondiale di elettricità, ovvero 415 terawattora (Twh). Nello scenario di base prospettato da IEA, questo consumo globale di elettricità per i data center dovrebbe raddoppiare e raggiungere circa 945 TWh entro il 2030, pari a poco meno del 3% del consumo globale di elettricità previsto in quell’anno. In tale scenario, l’intelligenza artificiale costituirà il fattore più significativo per l’aumento dei consumi, con una domanda di elettricità proveniente dai data center ottimizzati per la AI che è prevista più che quadruplicare entro il 2030. L’ascesa dell’intelligenza artificiale,aggiunge il rapporto, sta velocizzando la diffusione di server accelerati ad alte prestazioni, e portando di conseguenza a una maggior densità di potenza nei data center.

Visto in prospettiva, il problema non è certo una questione semplice, né sottovalutabile. Anzi, si configura come una sfida assolutamente prioritaria da affrontare, almeno per una duplice ragione. Da un lato, il consumo di energia rappresenta una delle principali voci di costo per i data center, dall’altro il loro funzionamento produce un notevole impatto ambientale, contribuendo alle emissioni di gas serra e al riscaldamento globale.

Queste ed altre ragioni stanno portando i gestori di data center nel mondo a collaborare strettamente con i produttori di hardware, semiconduttori e chip elettronici per implementare soluzioni innovative a diversi livelli e in differenti campi disciplinari. Uno di questi è la progettazione di nuovi chip elettronici, tra cui le CPU (central processing unit) e gli acceleratori AI basati su GPU (graphics processing unit), sviluppati in maniera specifica per elaborare con efficienza i workload di intelligenza artificiale. Ma si tratta anche di attuare un re-design delle schede elettroniche, delle motherboard e dei server rack, per creare layout ottimizzati in grado di facilitare il raffreddamento. C’è poi tutta l’attività di ricerca e sviluppo necessaria per innovare i sistemi di raffreddamento. L’obiettivo finale è sviluppare, progettare e implementare soluzioni per ottimizzare l’efficienza energetica e la sostenibilità dei centri dati, sfruttando, ad esempio, fonti di energia rinnovabile e puntando su sistemi di raffreddamento di nuova generazione.

Chip AI, spingono al limite il classico “air cooling”

I sistemi di raffreddamento a liquido, o “liquid cooling”, non si possono propriamente considerare una novità in senso assoluto, in quanto le applicazioni di questa tecnologia nel settore informatico esistono da molto tempo. Tuttavia, si può certamente parlare di ‘rinascita’ del sistema di raffreddamento a liquido, in corrispondenza con il trend di espansione dell’intelligenza artificiale e del calcolo ad alte prestazioni (high performance computing – HPC). E ciò perché la quantità di calore generato dai chip AI per gestire questi workload ‘compute-intensive’ sta ormai portando al limite le capacità di dissipazione dei tradizionali sistemi di raffreddamento ad aria, e rendendo il liquid cooling una strada indispensabile da percorrere per migliorare la gestione termica.

Tra i sistemi di raffreddamento a liquido esistenti nei moderni data center dedicati al supporto dei workload AI (AI data center) e HPC se ne può però citare uno particolarmente innovativo e ingegnoso, in grado di sfruttare anche il potere refrigerante dell’acqua di mare: si tratta del sistema di liquid cooling realizzato nel più grande insediamento di data center AI in Portogallo.

Infrastruttura di calcolo accelerata da GPU, ma sostenibile per i moderni Data center

L’imponente complesso di centri dati, che lo scorso maggio è stato aperto alla visita, per mostrare agli esponenti della stampa internazionale i risultati raggiunti, si chiama Start Campus e sta sorgendo a Sines, piccola cittadina situata sulle coste atlantiche del Portogallo, circa 160 km a sud di Lisbona.

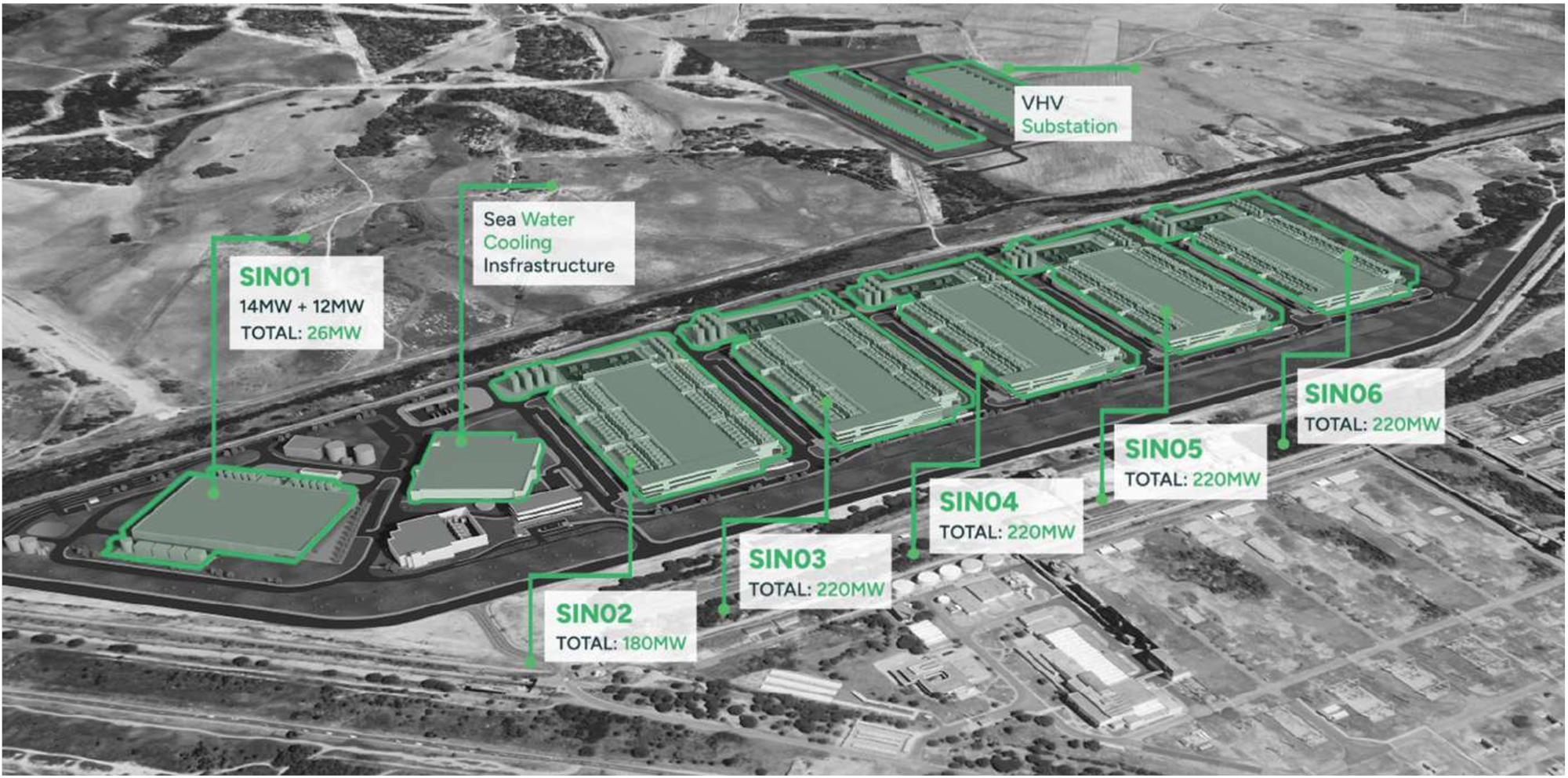

Dei sei data center previsti in costruzione, SIN01, al momento in cui scriviamo, è l’unico già realizzato, è già operativo dal quarto trimestre 2024, ed è progettato per arrivare a erogare una potenza complessiva di 26 megawatt (MW). Tuttavia, quando anche gli altri cinque centri dati saranno realizzati e diventeranno operativi, il complesso di edifici potrà erogare una potenza totale di 1,2 gigawatt (GW). Start Campus “utilizzerà al 100% energia rinnovabile” ed è stato dichiarato dal governo portoghese un progetto di interesse nazionale, che può contare su un investimento di 8,5 miliardi di euro, attuato dalle società Davidson Kempner e Pioneer Point Partners. Il progetto si propone di “creare il più grande e sostenibile ecosistema dati d’Europa”: per raggiungere l’obiettivo Start Campus sta collaborando con il partner tecnologico Schneider Electric.

Gestione termica dei chip: i benefici del ‘liquid cooling’ con acqua di mare

I centri dati sono infrastrastrutture che ospitano server, sistemi di storage, attrezzature di networking ed altri componenti, che includono i sistemi di climatizzazione e regolazione della temperatura per mantenere gli apparati IT in condizioni ottimali di funzionamento. Ci sono anche altri dispositivi, tra cui i gruppi di continuità, o UPS (uninterruptible power supply), e i generatori di backup (gruppi elettrogeni), che hanno il compito di garantire l’alimentazione del data center anche in caso di interruzioni della corrente elettrica.

In questo ambito, e in tema di efficientamento e raffreddamento del data center, Schneider sostiene di poter mettere in campo una gamma completa di soluzioni tecnologiche, attraverso una strategia che definisce “from grid to chip and chip to chiller”. In sostanza, una serie di prodotti e tecnologie che puntano a coprire la gestione termica del centro dati a livello end-to-end, lungo l’intero percorso in cui il calore viene generato: quindi dall’inizio, nel momento in cui la corrente entra nel data center attraverso la rete elettrica e passa nei sistemi di distribuzione elettrica e negli UPS, a quando l’energia attraversa l’infrastruttura di calcolo (CPU, GPU server) che genera la maggior parte del calore, fino al momento in cui il calore generato dai chip e dai server deve essere dissipato e trasportato lontano dal data center.

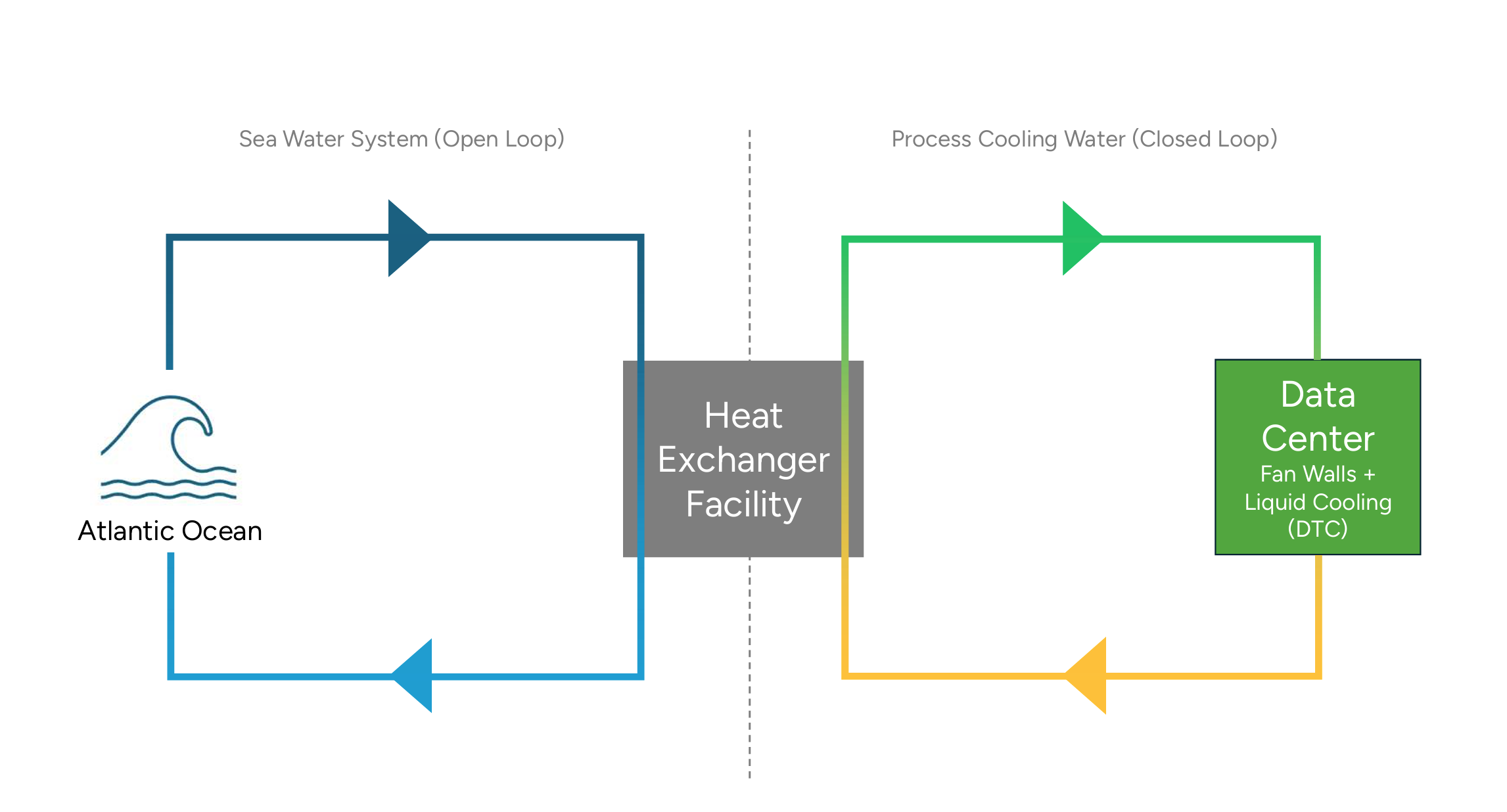

Per la componente “grid to chip”, Schneider ha fornito a Start Campus una serie di prodotti e soluzioni appartenenti alla suite EcoStruxure, tra cui dispositivi UPS, trasformatori in media tensione, quadri in media tensione, rack, sistemi di contenimento, busbar, software di gestione. La componente “chip to chiller” è invece quella in cui la collaborazione tra Start Campus e Schneider ha permesso di realizzare un innovativo sistema di raffreddamento a liquido: in sostanza, l’acqua dell’oceano, pompata dal bacino di una vicina centrale elettrica dismessa, va a refrigerare, tramite uno scambiatore di calore, il liquido di raffreddamento che scorre a circuito chiuso nel sistema di termoregolazione dei chip, costituito essenzialmente da CDU (coolant distribution unit). Questo sistema di liquid cooling è poi integrato e completato con impianti di raffreddamento ad aria.

Attraverso un sistema di liquid cooling che sfrutta acqua di mare, Start Campus punta a perseguire l’obiettivo di raggiungere un basso PUE (power usage effectiveness), di 1.1, che indica un’elevata efficienza energetica. Per inciso, PUE è una metrica per misurare l’efficienza energetica di un data center, e allo stato attuale, mediamente, al livello globale si attesta sul valore 1.56, secondo i dati pubblicati dall’Uptime Institute nella Global Data Center Survey 2024. In aggiunta, sempre sfruttando il potere refrigerante dell'oceano, il progetto ha anche l’obiettivo di arrivare a ottenere un WUE (water usage effectiveness) pari a 0, rendendo Start Campus “Net Zero” entro il 2030, attraverso una drastica riduzione delle emissioni di gas serra.

Progettare la corretta infrastruttura di raffreddamento per i data center

Come accennato, i sistemi di alimentazione, raffreddamento e i rack dei data center tradizionali non sono più sufficienti per i server GPU-based, organizzati in cluster AI ad elevata densità. Il calore che i chip AI generano è molto maggiore, perché la loro potenza computazionale e l’energia necessaria per il loro funzionamento sono maggiori. Finora, spiega Andrew Bradner, senior vice president per l’area Cooling Business di Schneider Electric, la tradizionale tecnologia di raffreddamento ad aria aveva rappresentato il sistema più diffuso per controllare la gestione termica di sistemi, che al massimo arrivavano a 50 kilowatt (kW) per rack. Tuttavia, quando si tratta di gestire workload AI che possono richiedere 150 kW e oltre, l’aggiunta all’infrastruttura data center di un sistema di raffreddamento a liquido diventa una necessità. Riconoscendo questa sfida, Schneider ha unito le forze con Nvidia per rispondere alle nuove esigenze dei data center AI, creando pool di esperti, appartenenti a entrambe le organizzazioni: l’obiettivo della partnership è quello di sviluppare in maniera congiunta ‘reference designs’ dell’infrastruttura fisica, sia per gli scenari in cui occorre aggiornare l’esistente, sia nei casi in cui si deve realizzare ex novo data center progettati appositamente per i workload AI. I progetti di riferimento sviluppati si propongono di fornire agli operatori di data center la guida e i dettagli tecnici per razionalizzare e accelerare l’implementazione di questi cluster AI ad elevata densità.

Sempre nell’ottica di facilitare le attività di simulazione, ottimizzazione e gestione dell’energia “dalla grid al chip” si pone anche l’annuncio, lo scorso marzo, dell’introduzione di un gemello digitale (digital twin) all’avanguardia, che, dichiara Schneider, permette di progettare e simulare con precisione il fabbisogno di energia di data center che vengono definiti “AI factory”. Tra le varie funzionalità, la soluzione fornisce l’abilità di simulare, gestire e ottimizzare l’uso dell’energia a livello di chip, migliorando l’efficienza complessiva, ed è il risultato della collaborazione tra Schneider Electric, Nvidia, che ha sviluppato il progetto Nvidia Omniverse Blueprint per i gemelli digitali delle AI factory, ed ETAP, società californiana fornitrice a livello globale di soluzioni software per sistemi elettrici, che coprono le fasi di progettazione e ingegnerizzazione, includendo anche la gestione delle operation e della manutenzione. In questo modo Schneider ed ETAP puntano a rendere possibile lo sviluppo di digital twin in grado di di fondere molteplici input, per sistemi meccanici, termici, sistemi di networking ed elettrici, al fine di simulare il funzionamento di una AI factory. La collaborazione, aggiunge Schneider, è destinata a trasformare la progettazione e le operazioni delle AI factory, fornendo migliori insight e maggior controllo sui sistemi elettrici e sui requisiti di energia, e si prefigge di costituire una opportunità per ottenere significativi incrementi di efficienza, affidabilità e sostenibilità.

Sottolineando come il futuro della tecnologia di gestione termica delle AI factory sia strettamente legato ai sistemi di raffreddamento a liquido, Bradner ha collocato in tale contesto anche la recente strategia di acquisizione da parte di Schneider di una quota di controllo in Motivair Corporation: quest’ultima possiede infatti un’ampia gamma di prodotti focalizzati sulla fornitura di soluzioni di cooling personalizzate per infrastrutture critiche. Assieme a Motivair, ha chiarito Bradner, Schneider potrà accelerare il suo impegno per supportare l’evoluzione del calcolo accelerato, attraverso una gamma completa di prodotti, affiancata da competenze, servizi e capacità di industrializzazione senza pari.