Internet of Everything, ovvero il concetto che si basa sull'interconnessione di dispositivi, persone, processi e dati, prevede l'acquisizione su base continuativa di dati dalle più diversificate attività quali vendita al dettaglio, trasporti, gestione di infrastrutture, fabbricazione, estrazione di minerali, produzione di cibo, sicurezza e numerose altre ancora. In base ai risultati di uno studio condotto da Cisco un negozio al dettaglio di grandi dimensioni colleziona circa 10 GB di dati all'ora e trasmette 1GB di questi a un data center. Uno stabilimento produttivo automatizzato può generare circa 1TB di dati all'ora dei quali circa 5 GB potrebbero essere memorizzati, mentre operazioni di estrazione su vasta scala possono produrre fino a 144 TB di dati all'ora. I servizi basati su cloud, ovvero la chiave di volta che permetterà di trasformare i dati acquisiti in informazioni utili, dovranno affrontare problematiche di notevole entità per gestire in modo adeguato l'impressionante mole di dati prodotta da un numero crescente di applicazioni IoE. L'energia è senza dubbio la risorsa principale consumata dai data center, ovvero il nucleo centrale degli odierni servizi cloud. Nel corso del ciclo di vita, stimato in tre anni, il costo per alimentare un server è superiore al prezzo dell'apparecchiatura stessa. Inoltre è necessario considerare il costo legato al funzionamento dei sistemi di raffreddamento, elementi critici per mantenere la temperatura operativa delle apparecchiature entro limiti di sicurezza. La minimizzazione di questi costi è un problema serio per gli operatori dei data center, che tendono a scegliere come teatro per le loro operazioni i Paesi dai climi più freddi - come ad esempio la Scandinavia e l’America del Nord Ovest - dove sono tra l’altro disponibili fonti di energia a basso costo come i generatori idroelettrici. Gli operatori inoltre stanno cercando di impostare temperature di funzionamento massime più elevate per le loro apparecchiature, sempre con l'obiettivo di risparmiare sui costi di raffreddamento. Nello stesso tempo, nel tentativo di determinare le migliori modalità per gestire il calore indesiderato, gli operatori hanno riconosciuto l'importanza di curare la causa: migliorare l'efficienza energetica complessiva delle apparecchiature dei data center al fine di ridurre il più possibile i costi operativi.

Affrontare cause e sintomi

Al fine di ottimizzare l'efficienza in ogni punto, è necessario apportare modifiche a tutte le componenti del sistema, dai server agli alimentatori al software per la gestione del sistema. Vale tuttavia la pena notare che il consumo di potenza di picco continua ad aumentare a causa del costante incremento della capacità di elaborazione. Il consumo di una tipica scheda per server è passato da poche centinaia di Watt agli attuali 2 o 3kW, che potrebbero diventare 5kW (o più) in un prossimo futuro. Di conseguenza la differenza tra la potenza minima richiesta dal server in presenza di carichi ridotti e la potenza a pieno carico tende ad aumentare. Le architetture di distribuzione della potenza sono diventate via via più flessibili e integrano funzionalità di tipo adattativo in real-time per garantire un livello di efficienza ottimale in tutte le condizioni operative.

Un'architettura di potenza adattabile

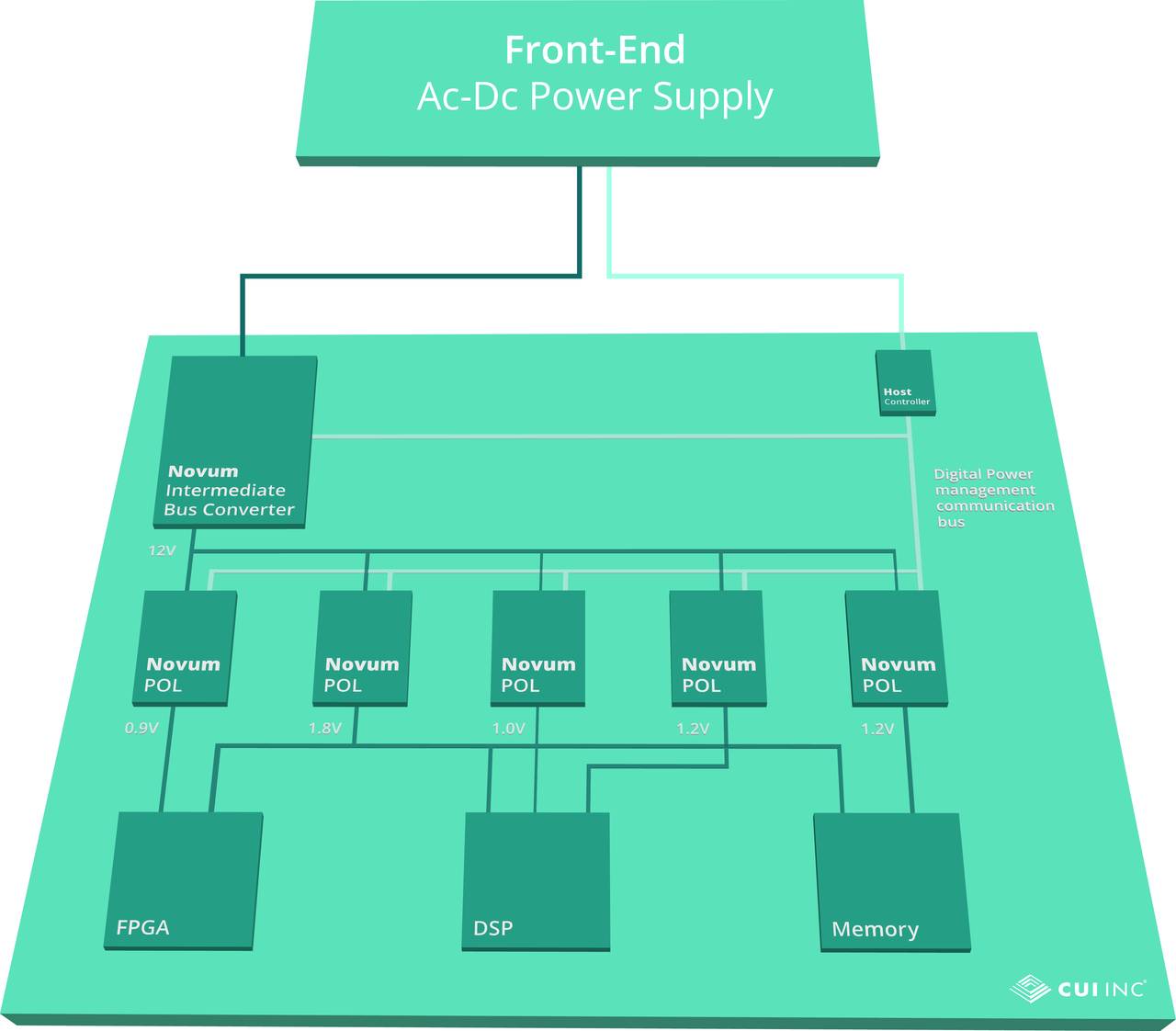

Consideriamo lo schema di un'architettura di potenza distribuita o Dpa (Distributed power architecture) che risulta composta da un convertitore Ac/Dc front-end che fornisce un ingresso di 48 Vdc a un convertitore di bus intermedio o Ibc (Intermediate Bus Converter). Quest'ultimo è un bus intermedio a 12 V che alimenta i convertitori Dc-Dc di tipo PoL (Point of Load) a bassa tensione posizionati in prossimità ai component che richiedono più potenza come processori, SoC o Fpga. Molteplici regolatori PoL possono essere utilizzati per alimentare il core, gli I/O e altri domini di tensione. L'uscita del front-end di 48 Vdc e la tensione del bus intermedio di 12 V sono stati scelti per minimizzare le perdite legate alla conversione verso il basso e le perdite proporzionali alla corrente e alla distanza delle schede del server che devono essere alimentata. In ogni caso, viste le variazioni in termini di corrente del core, assorbimento di corrente, massima potenza e differenza tra potenza a pieno carico e in assenza di carico, queste tensioni di valore fisso non sono adatte a garantire l'efficienza ottimale. La possibilità di impostare tensioni differenti e variarne il valore dinamicamente in tempo reale consente al sistema di adattarsi su base continua per ottimizzare l'efficienza.

Il controllo mediante PMBus

Il protocollo PMBus mette a disposizione una struttura standard industriale per consentire la comunicazione con i convertitori di front-end, intermedi e PoL connessi e controllati in maniera digitale. Un controllore host può monitorare lo stato dei convertitori e inviare comandi per ottimizzare le tensioni di ingresso e uscita nonché gestire altri aspetti come ad esempio abilitazione/disabilitazione, impostazione dei margini della tensione, gestione dei guasti, messa in sequenza, tempi di salita e rilevamento. Nel momento in cui i progettisti di sistemi sviluppano modalità sempre più efficaci per sfruttare le risorse di controllabilità messe a disposizione da PMBus, le architetture di sistema evolvono verso un modello di tipo "software-defined" (ovvero definite tramite software) con passibilità di risposta in tempo reale al fine di ottimizzare l'efficienza. Tra le tecniche più efficaci attualmente utilizzate per ottimizzare l'efficienza si possono segnalare le seguenti: Dbv (Dynamic bus voltage), Avs (Adaptive voltage scaling) e attivazione multi-core su richiesta. La tecnica Dbv permette di regolare dinamicamente la tensione di bus intermedia in base alle condizioni di carico prevalenti. Nel caso il server richieda una potenza di elevato valore, il PMBus può dare istruzioni affinché il convertitore Ibc fornisca una tensione di uscita più elevata al fine di ridurre la corrente di uscita e minimizzare nel contempo le perdite di distribuzione. Avs è una tecnica utilizzata dai processori ad alte prestazioni di fascia alta per ottimizzare sia la tensione di alimentazione sia la frequenza di clock al fine di assicurare che le richieste di elaborazione siano sempre soddisfatte con i consumi più bassi. La tecnica Avs prevede anche la compensazione automatica degli effetti delle variazioni di processo del silicio e delle fluttuazioni della temperatura di funzionamento. Al fine di supportare questa tecnica le specifiche PMBus sono state recentemente riviste con la definizione di AvsBus, grazie al quale un convertitore PoL può rispondere alla richiesta di variazione adattativa della tensione proveniente dal processore collegato. L'attivazione multi-core su richiesta, infine, fornisce un mezzo per attivare o togliere l'alimentazione ai singoli core di un processore con più core in risposta alle variazioni del carico. Ovviamente la disabilitazione dei core non utilizzati in presenza di carichi di elaborazione ridotti contribuisce a ridurre sensibilmente i consumi di energia.

Tecniche adattative e potenziali risparmi

Quelle appena descritte sono le prime funzionalità di natura adattativa che sono state utilizzate nel momento in cui i costruttori di alimentatori hanno iniziato a introdurre le architetture definite via software. È verosimile ipotizzare lo sviluppo di numerose altre tecniche, favorite dalla disponibilità di alimentatori Ac-Dc front end compatibili con PMBus, come ad esempio PSE-3000 e PSA-1100, come pure gli Ibc digitali Novum e i PoL Dc-Dc non isolati digitali di CUI. La costante ottimizzazione delle architetture di conversione di potenza e delle tensioni del bus garantirà sensibili miglioramenti per ogni tipo di convertitore. Si consideri ad esempio un alimentatore composto da un convertitore Ac/Dc front end (efficienza media del 95%), un convertitore Ibc (operante con un'efficienza del 93%) e un convertitore PoL (operanti con un'efficienza dell'88%). Prendendo in considerazione tutti e tre i convertitori, il 22,2% della potenza in ingresso è dissipata sotto forma di calore. Se si potesse aumentare dell'1% l'efficienza di ogni stadio, sarebbe possibile ridurre al 19,6% lo spreco di energia. Ciò rappresenta un miglioramento del 12%, una percentuale senza dubbio significativa. Senza dimenticare che la riduzione dei requisiti di raffreddamento si traduce in un ulteriore risparmio energetico. La comprensione della modalità di utilizzo della potenza da parte dei data center e l’impiego del software per la gestione e l'assegnazione in modo intelligente di questa potenza è una strategia che permette di conseguire risparmi significativi. Una tale virtualizzazione dell’infrastruttura di potenza rende la potenza stessa una risorsa di tipo flessibile e può contribuire a migliorare il tasso di utilizzo in misura che può arrivare al 50% (a parità di quantità di potenza). Ciò non solo permette di migliorare l’efficienza in termini di potenza consumata, ma anche di evita anche le spese che è necessario sostenere per l’acquisto di risorse aggiuntive che non risultano necessarie. Virtual Power Systems, un’azienda di riferimento nel settore della Software Defined Power, ha di recente sottoscritto un accordo con CUI al fine di integrare la propria soluzione software in un'unità hardware, denominata ICE Block, grazie a quale sarà possibile una gestione più efficiente delle sorgenti di potenza all’interno di data center ed ecosistemi simili.